La poco provechosa teoría de Robert Brenner sobre el estancamiento mundial

Seth Ackerman

La teoría de Robert Brenner sobre la economía mundial posterior a 1973 –que describe una larga era de «estancamiento» causada por un exceso crónico de capacidad industrial– es lógicamente dudosa y no se ajusta a los hechos. Pero el mayor problema de la teoría es su política.

Durante los últimos veinticinco años, el historiador económico de la UCLA Robert Brenner, colaborador desde hace mucho tiempo de la New Left Review, ha desarrollado una teoría cada vez más influyente de lo que él llama «la larga recesión», la desaceleración económica mundial que comenzó en 1973 con el fin del boom de la posguerra.

Según Brenner, durante medio siglo la economía mundial se ha estancado bajo el peso de una larga crisis de rentabilidad provocada por el exceso crónico de capacidad de la industria manufacturera mundial, un problema que se hizo sentir por primera vez con la reincorporación de las empresas alemanas y japonesas de la posguerra a unos mercados de exportación ya saturados, pero que no ha hecho más que empeorar con el tiempo.

Para Brenner, el exceso de capacidad crónico es el síntoma de un fallo en el mecanismo económico del capitalismo, derivado de la anarquía no planificada de la producción de mercado: las empresas de las industrias saturadas, cargadas con costes irrecuperables en forma de capital fijo, carecen de incentivos para retirarse de las líneas de negocio no rentables, lo que da lugar a acumulaciones irresolubles de exceso de capacidad que generan una competencia feroz, el hundimiento de las tasas de beneficio y, en última instancia, el estancamiento.

La política de la tesis de Brenner puede no ser obvia a simple vista, pero pudimos vislumbrarla a principios de este año a través de un comentario del sociólogo de Berkeley Dylan Riley, coautor en alguna ocasión de la tesis de Brenner, en el que criticaba a ciertos socialistas por lo que Riley consideraba sus evaluaciones excesivamente indulgentes de las políticas industriales de la administración Biden.

Independientemente de los méritos de su caso, lo notable del artículo de Riley era el uso que era capaz de hacer del marco económico de Brenner al servicio de un argumento político: La Bidenomics, en su opinión, dará lugar a «una exacerbación masiva de los problemas de exceso de capacidad a escala mundial», y este hecho, a su juicio, expone a los socialistas «neokautskianos» como carentes de una «respuesta creíble a la lógica estructural del capital».

Crisis de la teoría

Puede que algunos lectores sigan perplejos sobre cuál es exactamente la conexión. ¿Por qué la perspectiva de, digamos, un exceso de capacidad en la industria mundial de paneles solares debería influir de un modo u otro en cómo los socialistas juzgan algo como la Ley de Reducción de la Inflación? Como señaló Eric Levitz, de New York Magazine, un «exceso mundial de tecnología con bajas emisiones de carbono» es difícil de ver como un escenario de pesadilla, por decirlo suavemente.

Pero lo que podría parecer un non sequitur se vuelve menos misterioso una vez que se ha captado el subtexto político que subyace a la teoría de Brenner sobre la larga recesión.

Unos años antes de presentar su tesis en un número de 1998 de la New Left Review, Brenner dio una charla a sus compañeros del grupo socialista Solidarity sobre el problema de cómo los revolucionarios deberían relacionarse con los socialdemócratas. (La charla se publicó con el título «El problema del reformismo»).

La cuestión era apremiante porque el reformismo, como él mismo explicó, era «nuestro principal competidor político» y «el hecho ineludible es que, si queremos atraer a la gente a una bandera socialista-revolucionaria y alejarla del reformismo, no será generalmente a través de superar a los reformistas en términos de programa. Será a través de nuestra teoría: nuestra comprensión del mundo».

Lo que distingue al reformismo del socialismo revolucionario no es su apoyo a las reformas; los revolucionarios también buscan reformas. De hecho, «como socialistas, vemos la lucha por las reformas como nuestro principal asunto». La verdadera base de la división radica más bien en los intereses materiales personales de los reformistas, así como en su teoría del capitalismo.

La base social del reformismo, explicó Brenner, se encontraba en las filas de las burocracias sindicales y los aparatos de los partidos socialdemócratas. Dado que sus intereses organizativos se veían inevitablemente amenazados por estallidos de lucha de clases sin tapujos, los reformistas siempre se opusieron a los movimientos militantes desde abajo. Instaron a los trabajadores a limitar sus acciones a votar a los socialdemócratas el día de las elecciones y a respaldar las acciones sindicales oficiales en el trabajo. En otras palabras, los reformistas quieren que los trabajadores pongan su destino en manos de los reformistas.

Por eso siempre estaban afirmando que «la intervención del Estado puede permitir al capitalismo lograr estabilidad y crecimiento a largo plazo»; que la clase obrera puede «utilizar» al Estado para perseguir esos objetivos «en su propio interés». Los reformistas tienen que mantener estas posiciones porque sin promesas como éstas, dada su oposición a la lucha de clases, el reformismo y sus organizaciones no tendrían nada que ofrecer a la clase obrera.

Del mismo modo, la praxis de los revolucionarios debe permanecer estrechamente ligada a su teoría de la crisis económica. Los socialistas revolucionarios deben subrayar siempre que «las crisis surgen de la naturaleza intrínsecamente anárquica del capitalismo» y que, debido al carácter «no planificado» del sistema, «los gobiernos no pueden evitar las crisis». Sólo entonces podrían argumentar ante los trabajadores que el reformismo no puede y no funcionará, independientemente de las supuestas buenas intenciones de los reformistas.

Por eso, según Brenner, «para los revolucionarios, su argumento de que los periodos prolongados de crisis están integrados en el capitalismo tiene tanto peso».

Brenner no fue el primero en elevar la teoría de la crisis a un papel tan central en la práctica política socialista. La conexión ha sido un elemento básico del marxismo desde el estallido de la gran controversia revisionista en la década de 1890. Cuando Eduard Bernstein, el protegido convertido en apóstata de Marx y Engels, hizo un llamamiento a la socialdemocracia para que adoptara una vía reformista hacia el socialismo, situó la cuestión de la crisis capitalista en el centro de su argumentación: las crisis eran cada vez menos frecuentes y, sobre todo, menos apocalípticas a medida que el capitalismo maduraba, argumentaba Bernstein. Dado que el escenario del colapso total parecía cada vez más lejano, la opción revolucionaria perdía tanto su plausibilidad como su justificación.

La salva de Bernstein obligó a los defensores de la ortodoxia marxista, en sus diversos matices, a afilar sus propios argumentos teóricos, y en la década de 1920 había dos polos de análisis identificables en la teoría marxista de la crisis: El punto de vista «infraconsumista» de Rosa Luxemburgo, que subrayaba la insuficiencia del poder adquisitivo de la clase obrera como fuente principal de las tendencias a la crisis del sistema; y la teoría de la «desproporcionalidad» del socialdemócrata alemán Rudolf Hilferding, que atribuía la raíz de las crisis a la recurrencia de desajustes accidentales entre la producción de las distintas ramas de la industria, un peligro derivado de la naturaleza «ciega» y no planificada de la inversión capitalista.

Al volver la vista atrás a estos debates, lo que salta a la vista es el reflejo perenne, entre los marxistas de cierta mentalidad, de juzgar las teorías de la crisis según un criterio de irreformabilidad: la fuente de la crisis debe ser algo que se pueda describir de forma plausible como inerradicable sin alguna supresión revolucionaria no especificada del modo de producción existente.

Ahora bien, hay razones sensatas para esperar que las crisis económicas bajo el capitalismo surjan de fuerzas que reflejan los intereses creados de los propios capitalistas de un modo u otro –en cuyo caso, atacar las raíces de la crisis requiere atacar los intereses capitalistas–. Pero la irreformabilidad real resulta ser un objetivo enloquecedoramente móvil.

Tomemos como ejemplo la teoría de la crisis de Hilferding, que atribuía las turbulencias económicas a «desproporciones» en el patrón de inversión capitalista, derivadas del desarrollo «anárquico» y «no planificado» del sistema.

Al igual que Brenner en la actualidad, Hilferding –el principal experto económico del Partido Socialdemócrata Alemán de entreguerras– sostenía que sólo la planificación podía resolver el problema de las desproporciones. Señalaba el crecimiento de los cárteles de la industria privada desde finales del siglo XIX: eran la prueba de que los propios capitalistas se habían visto obligados a aceptar la lógica de la planificación para estabilizar unos mercados cada vez más caóticos.

Sin embargo, los cárteles eran ineficaces en última instancia: mientras siguieran siendo iniciativas puramente privadas y voluntarias, eran incapaces de poner orden en sus industrias porque no podían disciplinar eficazmente a sus miembros. Para estabilizar la economía de forma duradera, el Estado tendría que llevar a cabo una planificación global.

Desde el punto de vista actual, el mecanismo de crisis de Hilferding podría parecer a prueba de reformas: después de todo, hoy en día se supone que la planificación de los precios y la producción es una medicina demasiado fuerte para que el capitalismo se la trague.

Pero en los años 30, Hilferding fue atacado con dureza por los socialistas de su izquierda por lo que consideraban implicaciones reformistas de su teoría. En los años 30, muchos izquierdistas consideraban que la «planificación» era el camino preferido por la clase dominante para la estabilización económica, la vía hacia la recuperación que suponía la menor amenaza para el statu quo.

Recordemos la historia de los años de Roosevelt: el «Primer New Deal» de 1933-35, centrado en la Ley de Recuperación Industrial Nacional –con su cartelización obligatoria de la economía privada y la imposición de precios mínimos obligatorios y cuotas de producción– fue la fase «conservadora». El «Segundo New Deal» que comenzó en 1935 –con sus medidas de estado del bienestar, programas de empleo y leyes laborales favorables a los sindicatos– fue la fase «radical».

Lo mismo ocurrió en Europa, donde el ala derecha de los movimientos socialistas y obreros abrazó el «planismo» del New Deal propugnado por el Partido Laborista belga y su teórico Hendrik De Man. Los socialistas y comunistas de izquierdas denunciaron las supuestas connotaciones fascistas del planismo y se adhirieron a las doctrinas neoluxemburgistas del subconsumo. Para ellos, domesticar la anarquía de la producción parecía potencialmente alcanzable bajo el capitalismo. Lo que parecía impensable era una redistribución drástica de la riqueza.

Pero pocos años después la rueda volvería a girar, cuando una combinación de guerra y presiones desde abajo obligó al mundo capitalista a aceptar el redistribucionismo a una escala que antes parecía inconcebible. Las consecuencias fueron, por así decirlo, revolucionarias. En Gran Bretaña, la proporción de la renta nacional destinada al 50% más pobre, que había sido menos de la mitad de la proporción del 1% más rico en 1910, se disparó a más del doble de su nivel en 1950.

Así pues, era sólo cuestión de tiempo que el subconsumismo, considerado en su día como la doctrina radical de Rosa la Roja, pasara a ser visto como el paliativo de la clase dominante de John Maynard Keynes, enviando de nuevo a los teóricos de la crisis en busca de pastos más dorados.

El auge de la caída de la tasa de beneficios

En la década de 1970, el mundo capitalista sufrió una crisis muy diferente. Esta vez, no se trataba de atribuir el problema a la escasez de poder adquisitivo de las masas: a finales de los años sesenta y principios de los setenta se había producido una «explosión salarial» en todos los países industrializados, en medio del pleno empleo, la rigidez de los mercados laborales y una oleada de creciente militancia obrera.

En consecuencia, la llamada explicación de la crisis basada en la compresión de los beneficios –cuyo locus classicus fue el influyente libro británico Capitalism, Workers and the Profits Squeeze de Andrew Glyn y Bob Sutcliffe– ganó adeptos de inmediato entre los académicos marxistas y afines a Marx en el mundo anglosajón. (La teoría del profit-squeeze [exprimir los beneficios] se denomina a veces teoría del «wage-squeeze» [exprimir los salarios]; la idea, en cualquier caso, es que los beneficios estaban siendo exprimidos por los salarios).

La teoría de la compresión de los beneficios describía las turbulencias de los años setenta como una especie de imagen especular de la Depresión de los años treinta: al igual que la anterior calamidad se había visto exacerbada por unos salarios demasiado bajos, que socavaban la demanda agregada, ahora la militancia de la clase obrera había hecho subir demasiado los salarios, erosionando la tasa de beneficios y paralizando la inversión.

Inicialmente, este argumento atraía a todo el espectro marxista. Todos estaban de acuerdo en que, de hecho, las tasas de beneficio habían disminuido a medida que aumentaban los salarios. Y para un buen número de radicales, la teoría podía verse como una reivindicación del tipo de estrategia militante «transicional» defendida durante mucho tiempo por los trotskistas: exigir «reformas» calculadas como imposibles de realizar por el capitalismo. Los revolucionarios de los sindicatos, se decía, habían ayudado a impulsar a la clase obrera a mayores cotas de militancia, y las demandas salariales resultantes habían producido ahora una crisis en toda regla del capitalismo a la que los keynesianos de la clase dominante no tenían respuesta.

Sin embargo, una vez que quedó claro que la crisis de los 70 no conducía a la revolución, el relato del profit-squeeze pasó a verse desde la perspectiva opuesta: como una sanción ideológica a los planes de moderación salarial –«políticas de rentas»– defendidos durante mucho tiempo por los expertos keynesianos de los partidos socialdemócratas por motivos antiinflacionistas.

Desde el punto de vista de los radicales, a los Svengalis de la política de rentas y a sus amos políticos en las oficinas del gabinete les resultó demasiado fácil reunir reclutas dispuestos a la moderación salarial en las burocracias sindicales, cuyos líderes, a su vez, estaban demasiado dispuestos a ofrecer sus servicios a los ansiosos políticos socialdemócratas que esperaban «gestionar» la crisis en aras de un craso electoralismo.

En 1969, un libro titulado Marx and Keynes: The Limits of the Mixed Economy (Marx y Keynes: los límites de la economía mixta) fue publicado por Paul Mattick, un comunista consejista alemán y autodidacta adepto de la economía política marxiana que se había establecido en Estados Unidos en la década de 1920 para convertirse en un incansable –y, durante décadas, generalmente ignorado– evangelizador de las ideas del teórico polaco Henryk Grossmann, en gran parte olvidado, cuya obra de 1929, La ley de la acumulación y la descomposición del sistema capitalista, destacó por ser una de las pocas obras sustanciales del marxismo anterior a los años setenta que basaba firmemente su teoría de la crisis en la famosa «Ley de la tendencia a la baja de la tasa de ganancia» de Marx.

En la introducción de su libro, Mattick escribió: «Sostengo que la solución keynesiana a los problemas económicos que acosan al mundo capitalista sólo puede ser de utilidad temporal, y que las condiciones en las que puede ser eficaz están en proceso de disolución. Por esta razón, la crítica marxiana de la economía política, lejos de haber perdido su pertinencia, adquiere nueva relevancia por su capacidad de comprender y trascender tanto la ‘vieja’ como la ‘nueva’ economía.»

Cuando estos pronósticos parecieron hacerse realidad unos años más tarde, una cohorte de jóvenes marxistas de la Nueva Izquierda, en busca de una nueva teoría de la crisis a prueba de reformas, abrazaron a Mattick como su estrella polar y desempolvaron la conjetura de Marx sobre la caída de la tasa de ganancia (FROP por sus siglas en inglés). Uno de ellos, David Yaffe, que defendió prominentemente la FROP a lo largo de la década de 1970, expuso el caso sin rodeos en una reseña crítica del libro de Glyn/Sutcliffe que apareció en la New Left Review en 1973.

«La crisis de rentabilidad», escribió Yaffe, «lejos de ser causada por grandes aumentos salariales, resulta de las contradicciones de la propia producción capitalista que tiene su expresión en la tendencia a la caída de la tasa de ganancia.» Tomando a los teóricos de la compresión salarial como culpables de su apostasía, explicó su error en términos casi idénticos a los de Brenner discutiendo el problema del reformismo dos décadas más tarde:

Si el modo de producción capitalista puede garantizar, con o sin intervención gubernamental, el crecimiento continuado y el pleno empleo, entonces el argumento más objetivo en apoyo de la posición socialista revolucionaria se desmorona. La perspectiva reformista se convierte entonces en razonable.

Así, en el transcurso de la década de 1970, por un proceso de autoselección ideológica, el FROP llegó a estar, como dijo el difunto Simon Clarke en su estudio de la teoría marxista de la crisis, «asociado políticamente con un milenarismo sectario» que se hacía cada vez más conspicuo en ciertos sectores ultramontanos de la menguante izquierda marxista posterior a la década de 1960.

En un exasperado contragolpe publicado en 1973, Paul Sweezy denunciaba «una interpretación de la teoría de la acumulación de capital de Marx que parece ser compartida, con variaciones, por un número creciente» de economistas marxistas, un grupo para el que Sweezy personalmente se había convertido en «un blanco favorito». Esta escuela de pensamiento –de la que «Paul Mattick quizá merezca ser llamado el decano»– se caracterizaba por una «fetichización de la tendencia decreciente de la tasa de ganancia» y un enfoque general del marxismo que había «degenerado en una ortodoxia estéril».

Con los mattickistas acusando a sus oponentes marxistas de herejía y sus oponentes tachando a los mattickistas de fundamentalistas, es fácil ver cómo el FROP podría llegar a ser percibido, por marxistas y no marxistas por igual, como, para bien o para mal, el estándar más puro de la ortodoxia marxiana. Hasta el día de hoy, de hecho, se asume ampliamente que la FROP ha sido siempre la teoría marxista ortodoxa de la crisis.

Pero la verdad es casi lo contrario: en las ocho décadas transcurridas entre la muerte de Friedrich Engels y las crisis del petróleo de la OPEP, la FROP no desempeñó casi ningún papel en las diversas teorías sobre la crisis de la mayoría de las principales autoridades marxistas. Rosa Luxemburg era famosa por despreciar la idea. Karl Kautsky lo mencionó como un factor que tiende a promover la centralización del capital, pero no como una causa importante de crisis. El capítulo pertinente del enormemente influyente libro de texto de economía marxista de Sweezy de 1942, The Theory of Capitalist Development, señalaba que la ley «ha sido objeto de numerosas críticas tanto de seguidores como de oponentes» de Marx, y dedicaba toda una sección a «Una crítica de la ley». Ernest Mandel, en su Introduction to Marxist Economic Theory de 1967, incluyó una diligente sección de cinco páginas sobre la ley y luego la ignoró cuidadosamente durante el resto del libro.

Incluso hay buenas razones para dudar del compromiso del propio Marx con la idea. Está claro que el FROP era una teoría que Marx quería creer cierta. Al igual que los físicos y los matemáticos son conocidos por esperar que una teoría o teorema especialmente elegante acabe siendo confirmado por una prueba o experimento futuro, Marx quería encontrar una manera de hacer que el FROP funcionara porque, dentro del contexto de su teoría, conducía, como Duncan Foley dijo en su manual de economía marxiana de 1986, a «un hermoso desenlace dialéctico.»

Pero Marx era un estudioso escrupuloso, y cada vez que intentaba elaborar los detalles del concepto en sus notas y borradores de las décadas de 1850 y 1860, se encontraba –como ha demostrado el marxólogo alemán Michael Heinrich– perdido en un laberinto de álgebra que sólo podía demostrar que una tasa de ganancia decreciente era una posibilidad, no un resultado necesario del desarrollo capitalista.

La Ley de la Tendencia a la Caída de la Tasa de Ganancia entró en el corpus del pensamiento marxiano gracias a que Engels incorporó algunos de estos materiales en el tercer volumen de El Capital, publicado póstumamente. Pero, como señaló Sweezy en 1942, el análisis de Marx en esa sección no era «ni sistemático ni exhaustivo» y «como tantas otras cosas en el volumen III, quedó en un estado inacabado.»

¿Cuán central era, entonces, el FROP para la visión de Marx del capitalismo? En Marx’s Theory of Crisis, Clarke presentó un caso convincente: «Quizá el mejor indicio de la importancia que Marx concedía a la ley de la tendencia a la baja de la tasa de ganancia es que no la mencionó en ninguna de las obras publicadas en vida, ni le prestó mayor consideración en los veinte años de su vida que siguieron a la redacción del manuscrito en el que se basa el tomo tercero de El Capital.»

En otras palabras, exactamente un siglo antes de que los jóvenes discípulos de Mattick redescubrieran con entusiasmo el FROP, Marx había perdido definitivamente el interés por él.

En las décadas posteriores a 1973, el marxismo como fuerza política sufrió duras derrotas. Pero a nivel académico, disfrutó de un notable renacimiento. La economía marxista, en particular, experimentó un tremendo aumento en su nivel de sofisticación teórica y competencia técnica gracias a una generación de radicales que se habían incorporado a la academia durante la época de la guerra de Vietnam.

Una de las figuras más destacadas de esa cohorte fue Anwar Shaikh, de la New School for Social Research, que surgió en el transcurso de las décadas de 1970 y 1980 como el principal defensor académico del FROP y del enfoque más amplio del marxismo con el que se asocia: «marxismo clásico», en la terminología de Shaikh; «marxismo fundamentalista» (o, más educadamente, «marxismo ortodoxo») en boca de sus detractores.

Pero por muy ortodoxo que sea, Shaikh es un estudioso de estudiosos, no un doctrinario estrecho de miras. Su obra cumbre de 2016, Capitalism: Competition, Conflict, Crisis, un tratado de 1.026 páginas que presenta los frutos de su programa de investigación de cuatro décadas, es una obra de notable erudición, notable por su coherente claridad conceptual, su cuidadosa atención a las pruebas empíricas y su negativa a conformarse con alharacas o apelaciones a la autoridad. El libro de Shaikh hace por la economía política marxiana lo que Foundations of Economic Analysis de Paul Samuelson de 1947 hicieron por la economía neoclásica: asentarla sobre una firme base teórica fundamentada en los métodos modernos más rigurosos. Y entre los muchos temas que aborda está la versión de Shaikh –Shaikh diría la versión de Marx– de la teoría de la caída de la tasa de beneficio.

Así, para cuando Robert Brenner presentó su teoría alternativa de la tasa de ganancia decreciente, la teoría de la tasa de ganancia decreciente –el clásico FROP del tercer volumen de El Capital– había adquirido un extraño estatus dentro del marxismo. Nunca había sido especialmente popular entre las principales autoridades marxistas, y ahora estaba en muy mal estado gracias en parte al dogmatismo estridente de algunos de sus defensores más ruidosos. Y, sin embargo, se había beneficiado silenciosamente de dos décadas de cuidadosa e inteligente reconstrucción a manos de Shaikh y algunos otros estudiosos serios, entre ellos Duncan Foley y los investigadores franceses Gérard Duménil y Dominique Lévy.

Debido al estatus canónico del FROP clásico y a que, al igual que la versión de Brenner, siempre ha pretendido servir como teoría de la crisis «a prueba de reformas», las dos teorías merecen ser evaluadas una al lado de la otra.

Shaikh contra Okishio

La tasa de beneficio es la tasa de rendimiento que los capitalistas obtienen de sus inversiones en capital físico: máquinas, edificios, materias primas, etc. La aritmética es la misma que con cualquier otro tipo de inversión: Del mismo modo que una cuenta de ahorro que ofrece un interés del 5% paga un interés anual de 5 dólares por cada 100 dólares depositados, una tasa de beneficio del 5% significa que el capitalista medio obtiene 5 dólares de beneficio por cada 100 dólares invertidos en capital físico. (Obsérvese que esto significa que para cualquier nivel de beneficio, un mayor stock de capital implica una menor tasa de beneficio).

El punto de partida de la teoría marxiana clásica de la caída de la tasa de beneficio es la importancia de la mecanización que ahorra trabajo para el crecimiento económico. El crecimiento a largo plazo requiere un aumento de la productividad del trabajo –cada vez más producción por trabajador– y para conseguir un aumento de la productividad del trabajo la mano de obra debe normalmente estar equipada con cada vez más capital por trabajador.

La cuestión clave es el equilibrio entre estas dos tendencias. Si la tasa de crecimiento del capital por trabajador, en términos porcentuales, no va acompañada de una tasa de crecimiento de la productividad del trabajo al menos igual (también en términos porcentuales), entonces se necesitará una mayor cantidad de capital para obtener un volumen determinado de producción. Y si eso ocurre, a menos que la parte de la producción que se destina a beneficios aumente para compensar, la tasa de beneficio –beneficio por unidad de capital– caerá.

El concepto de Marx de la «tendencia a la baja de la tasa de beneficio» depende de la idea de que alguna fuerza está actuando dentro del proceso competitivo haciendo que sea, al menos, muy probable que, a largo plazo, la productividad del trabajo no consiga mantener el ritmo de la intensidad del capital y que la parte de la producción destinada a beneficios no aumente lo suficiente como para compensar. Pero, ¿cuál podría ser esa fuerza?

Durante todo el tiempo que se ha debatido el FROP de Marx, más de un siglo, una crítica en particular ha sido perenne. Recordemos que la tasa de beneficio es, por definición, el producto de dos términos: la parte de la producción que se destina a beneficios (en contraposición a los salarios); y el volumen de producción producido por unidad de capital. La primera de estas variables viene determinada por la lucha de clases entre el trabajo y el capital en torno al reparto del producto. La segunda viene determinada principalmente por los métodos técnicos de producción puestos en práctica por los capitalistas.

El desafío que los críticos siempre han planteado a la teoría de Marx es el siguiente: ¿Por qué un capitalista introduciría voluntariamente un método de producción que produjera una tasa de ganancia inferior a la predominante? La tasa de beneficio podría disminuir por muchas razones. Pero sin duda la causa menos plausible es la única variable sobre la que los capitalistas tienen un control directo y consciente: la elección de los métodos de producción.

Esta línea de pensamiento llevó a una larga serie de escritores, empezando por el estudioso ruso Mikhail Tugan-Baranovsky en una influyente monografía de 1901, a razonar que la «elección de la técnica» del capitalista debe, en todo caso, tener el efecto de empujar la tasa de beneficio constantemente al alza, no a la baja, como había afirmado Marx.

En 1961, el economista japonés Nobuo Okishio publicó un artículo histórico que demostraba que la crítica de Tugan al FROP era, al menos, lógicamente correcta: en un conjunto dado de precios de mercado dominantes, y suponiendo que no haya cambios en el salario real, cualquier método de producción que introduzca un capitalista que maximice el beneficio debe tener el efecto –una vez generalizado en toda la economía– de elevar, en lugar de reducir, la tasa general de beneficio.

La aparición del Teorema de Okishio, matemáticamente imponente, fue una razón clave –junto con los argumentos infructuosos de los creyentes más dogmáticos del FROP– para el descrédito de la teoría de la caída de la tasa de beneficio. A causa de ello, muchos estudiosos ampliamente alineados con el marxismo se convencieron de que la teoría había sido definitiva y científicamente desacreditada.

Fue en respuesta a la crítica de Okishio que Shaikh, a finales de la década de 1970, centró su investigación en los detalles del comportamiento competitivo a nivel de empresa e industria. Basándose en Marx, pero enriqueciéndose con el trabajo de algunos microeconomistas disidentes –especialmente el excéntrico (y muy conservador) teórico inglés de los precios de la posguerra P. W. S. Andrews– Shaikh desarrolló una teoría de la competencia intraindustrial que denominó (en contradicción con las categorías dominantes de competencia «perfecta» e «imperfecta») «competencia real».

La «teoría de la competencia real» proporciona a Shaikh el motivo maestro de su proyecto intelectual. Siembra el texto de Capitalism con ácidas caracterizaciones del proceso competitivo, formando un vívido retablo de miedo y depredación: es «antagónico por naturaleza y turbulento en su funcionamiento. Es el mecanismo regulador central del capitalismo y es tan diferente de la llamada competencia perfecta como la guerra lo es del ballet». La metáfora marcial está siempre presente: la competencia es «una guerra entre empresas». Es «una guerra por otros medios». Sigue la «racionalidad impuesta de la guerra». «Bellum omnium contra omnes».

En manos de Shaikh esto no es mera retórica; es capaz de demostrar formalmente que, dados ciertos supuestos plausibles sobre la evolución de la tecnología –a saber, que el conjunto de innovaciones factibles suele estar sesgado en la dirección de tecnologías que aumentan la productividad del trabajo, pero a costa de una mayor intensidad de capital–, el tipo de comportamiento competitivo ofensivo descrito por su teoría conducirá de hecho a una tendencia a largo plazo a la caída de la tasa de beneficio agregada.

La característica clave del comportamiento competitivo en la teoría de Shaikh es su tendencia implacable a la reducción agresiva de precios y costes. En la metáfora de la competencia como arma de guerra, el precio es el arma elegida.

En el modelo de Okishio, los capitalistas innovadores adoptan métodos de producción más eficientes con el fin de obtener mayores beneficios actuales cobrando el mismo precio que los competidores pero produciendo a menor coste. Pero para Shaikh, eso ignora la naturaleza intrínsecamente estratégica y antagónica de la competencia capitalista. En lugar de sentarse y disfrutar de un mayor flujo de beneficios al precio anterior, el capitalista innovador de Shaikh esgrime su recién descubierta superioridad de costes como un garrote, presionando su ventaja contra los rivales al recortar sin piedad el precio por debajo de lo que sus competidores pueden permitirse cobrar. No tiene más remedio que actuar así, según Shaikh, porque en el campo de la competencia capitalista, «haz a los demás antes de que te hagan a ti» es la máxima del juego.

Hay que decir que la crítica de Shaikh a Oshikio es ingeniosa. Los capitalistas individuales podrían preferir utilizar únicamente aquellos métodos de producción que aumentaran la tasa de beneficio. Pero no pueden, porque están atrapados en un juego competitivo destructivo que les obliga a adoptar métodos cada vez más intensivos en capital mientras recurren a la reducción de precios que destruye los beneficios en aras de la supervivencia competitiva.

De ahí el «bello desenlace dialéctico» señalado por Duncan Foley: la misma fuerza que hace posible la vitalidad del capitalismo –la innovación técnica impulsada por los beneficios– es también la fuente de su declive.

Escapar de la competencia

Sin embargo, todo esto sólo se sostiene si tal comportamiento es realmente «la norma en el mundo de los negocios», como afirma Shaikh. Aquí es donde Shaikh se equivoca, tanto desde el punto de vista de la lógica como de la evidencia.

Para Shaikh, la competencia entre empresas es como la guerra entre estados. Pero esta analogía debe ser inexacta, porque la mayor parte del tiempo la mayoría de los estados no están en guerra. Según la lógica de la analogía, Shaikh parece decir que la mayoría de las veces las empresas no compiten entre sí. Pero no está diciendo eso: a lo largo de todo su libro se opone a las teorías de la competencia imperfecta y el monopolio que pretenden restar importancia a la intensidad de la competencia intraindustrial.

La razón por la que la mayoría de los estados no suelen estar en guerra es que la guerra es costosa. Incluso los líderes que no tienen reparos en iniciar o intensificar una guerra de la que creen que pueden salir beneficiados –pensemos en Richard Nixon– suelen pasar gran parte de su tiempo en el poder intentando evitar guerras que, en su opinión, les dejarían en peor situación.

En la teoría de Shaikh, las empresas que adoptan innovaciones para reducir costes lo hacen con la intención bélica de perjudicar a sus competidores menos eficientes mediante la reducción de precios. Pero le cuesta explicar de forma creíble cómo se benefician de ello, incluso a largo plazo. En varios momentos del texto, cuando llega a este punto del argumento, su prosa se pierde en una nube de vaguedad poco habitual: la «ventaja de la empresa de bajo coste queda clara» por sus agresivos recortes de precios; demuestran a los competidores de mayor coste que «el futuro ha llegado», «que están condenados».

Pero, ¿y si los competidores no están de acuerdo en que están condenados? ¿Y si ellos también están dispuestos a aceptar una menor tasa de beneficios para seguir en el negocio? Entonces, el tipo de comportamiento bucanero que Shaikh presenta como una receta consagrada para el éxito competitivo sería, de hecho, ruinosamente arriesgado y, por tanto, algo que los capitalistas inteligentes intentarían evitar.

No se trata sólo de una especulación a priori. Un libro sobre fijación de precios escrito por «tres preeminentes expertos de McKinsey & Company» (The Price Advantage) aconseja a los directivos que «las guerras de precios rara vez tienen verdaderos ganadores –y pocos supervivientes sanos»–. Por eso, «las empresas mejor gestionadas hacen lo imposible por evitar las guerras de precios». La mayoría de las guerras de precios que se producen estallan por accidente, como resultado de una percepción y un cálculo erróneos: «La guerra de precios que se inicia como una táctica competitiva deliberada es algo raro, y más raro aún es la que logra un resultado positivo para la industria en general o para un proveedor específico dentro de la industria en guerra».

Un consejo casi idéntico se da en un libro de gestión (Confessions of the Pricing Man) del consultor de precios alemán Hermann Simon, fundador de la empresa de asesoría global Simon-Kucher. En su encuesta anual a directivos, el 82% de los encuestados que afirmaron que su empresa estaba inmersa en una guerra de precios creía que había sido instigada por un competidor; sólo el 12% dijo que su empresa la había iniciado como táctica deliberada. «A menos que se disponga de una ventaja de costes imbatible que impida a los competidores responder del mismo modo, es casi imposible establecer una ventaja competitiva sostenible mediante la bajada de precios», escribe Kucher.

Los expertos de McKinsey se hacen eco de esa afirmación, pero también la cuantifican: «Si alguna vez ha imaginado que reducir los precios para ganar cuota y aumentar los beneficios podría ser una estrategia sólida para su empresa, piénselo de nuevo. A menos que tenga una ventaja de costes dominante –con esto nos referimos a costes que sean al menos un 30% inferiores a los de la competencia–, reducir los precios desencadena con demasiada frecuencia una guerra de precios suicida». (En un momento dado, Shaikh caracteriza la ventaja de costes de la empresa innovadora en uno de sus ejemplos numéricos como «sólida, del orden del 10%»).

Así pues, para que la teoría de la competencia real de Shaikh sea válida, la innovación técnica en el mundo real tendría que estar impulsada por una estrategia competitiva que –según estos expertos– rara vez se ve y casi nunca funciona.

Pero no necesitamos basarnos en testimonios cualitativos. En los últimos veinte años, la creciente disponibilidad de conjuntos de datos masivos que miden las variables de producción a nivel de planta, así como las ventas de productos al por menor a nivel de transacción, han hecho posible observar directamente los tipos de procesos competitivos a micronivel que, en el pasado, entraban en los modelos de los economistas sólo en forma de supuestos «plausibles» (es decir, conjeturas acordadas profesionalmente).

Estos datos rechazan sistemáticamente la imagen de una competencia de precios implacable descrita en la teoría de Shaikh (y en la de Brenner), en la que las empresas compiten principalmente intentando vender el mismo producto que sus competidores pero más barato.

Más que el precio, la principal dimensión de la lucha competitiva es lo que un importante artículo de esta literatura denominó «demanda idiosincrásica» y lo que otros artículos llaman «atractivo del producto»: el número de unidades de un producto que una empresa puede vender a un precio determinado.

Un estudio muy citado de 2014 analizó datos de ventas a nivel de transacción de casi medio millón de productos fabricados por más de cincuenta mil empresas. «Nuestros resultados», concluyeron los autores, «apuntan a que las diferencias en la demanda (que podrían surgir de la variación de la calidad o el sabor) son la razón principal por la que algunas empresas tienen éxito en el mercado y otras no.»

El atractivo del producto explica entre el 50% y el 70% de la variación del tamaño de una empresa en un momento dado; menos del 25% se debe a diferencias de precio o coste. Cuando los autores analizan los cambios a lo largo del tiempo, «los resultados son aún más crudos», escriben. «Prácticamente todo el crecimiento de las empresas puede atribuirse a su atractivo».

La historia es la misma incluso en industrias que producen productos aparentemente estandarizados, como cajas de cartón corrugado y hormigón premezclado. Un trabajo seminal de 2011 realizado por economistas de la Oficina del Censo y la Universidad de Chicago estudió datos censales detallados a nivel de planta sobre la producción y los precios en miles de fábricas individuales precisamente en tales industrias. También encontraron una variación notablemente amplia y persistente entre las diferentes plantas en los niveles de demanda idiosincrásica. Y estas diferencias resultaron ser predictores mucho más fuertes de la supervivencia y el crecimiento de las empresas que la superioridad en costes o precios.

«Un aumento de una desviación típica en las perturbaciones de la demanda supone una disminución de la probabilidad de salida de 3 a 4 veces mayor que la disminución de la probabilidad de salida derivada de una desviación típica en la productividad física», escriben los autores. «Es difícil evitar la interpretación de que los efectos de la demanda son un determinante predominante de la supervivencia».

Shaikh resumió una vez con elegancia la imagen de Marx de la competencia capitalista como una lucha en dos frentes: una lucha contra el trabajo para reducir costes, en la que el arma predominante es la mecanización; y una lucha contra las empresas competidoras por la cuota de mercado, en la que el arma dominante es la reducción de precios.

Cada uno de estos procesos tiende a reducir la tasa de beneficios: el primero, elevando el nivel de intensidad de capital; el segundo, reduciendo la cuota de beneficios.

Sin embargo, la nueva investigación basada en microdatos confirma la centralidad de lo que podríamos llamar un tercer frente: la lucha contra la propia competencia, en la que el arma elegida es la diferenciación de productos. La diferenciación del producto desvincula el éxito competitivo del coste y el precio, permitiendo al capital trazar un camino alternativo, que preserve los beneficios, a través del laberinto de la competencia.

La teoría de Schrödinger

Independientemente de sus defectos, la teoría de la caída de la tasa de beneficio de Shaikh se basa en un rico marco conceptual que abre numerosas vías para la reflexión teórica. En comparación, la teoría de Brenner nos da mucho menos en qué pensar.

A primera vista, la teoría de Brenner parece sencilla: gracias a la entrada masiva de productores de bajo coste en las industrias manufactureras mundiales, surgió un problema de exceso de capacidad crónico que presionó a la baja los precios manufactureros y, por tanto, las tasas de beneficio globales. La consiguiente falta de rentabilidad provocó una baja inversión y un estancamiento del crecimiento.

Pero como ha señalado una larga serie de críticos –incluido Shaikh en su reseña de la obra de Brenner The Economics of Global Turbulence, publicada en un número de 2000 de Historical Materialism– una caída de los precios en un sector de la economía (el manufacturero en este caso) no debería tener ningún efecto particular sobre la tasa de beneficio global, porque los precios de producción de un sector son los precios de entrada de todos los demás sectores.

Brenner era perfectamente consciente de ello cuando escribió The Economics of Global Turbulence. Por eso incluyó un argumento alternativo: ¿Quizás, como subproducto de la caída de precios resultante del exceso de competencia, los salarios reales aumentaron, y esto fue lo que causó la caída de la tasa de beneficio?

Esta línea de argumentación parecería hacer de la teoría de Brenner una teoría de la compresión salarial. Brenner, sin embargo, es un crítico vehemente de las teorías de la compresión salarial, insistiendo (correctamente) en que la participación de los salarios no aumentó lo suficiente en las décadas de 1960 y 1970 como para explicar la magnitud de la caída observada en la tasa de beneficios.

Así que, más adelante, en The Economics of Global Turbulence, vuelve a su teoría original de que la caída de los precios en un sector provocó una caída general de la tasa de beneficios, aunque en otras partes del texto reconoce que eso no es posible.

Así, en lo que se refiere a las causas últimas del «estancamiento», el argumento de Brenner es una especie de gato de Schrödinger de las teorías de la crisis: es una teoría del exceso de competencia cuando se la mira y una teoría del estrangulamiento salarial cuando no se la mira. Como el gato, ninguna de las dos sobrevive al escrutinio.

(Shaikh no fue el único en juzgar la monografía de Brenner «difícil de leer» porque «los argumentos implicados aparecen en diferentes secciones, a veces son implícitos en lugar de explícitos, y pueden ser contradictorios»).

Hay más problemas a nivel teórico. La teoría de Brenner carece de un mecanismo lógicamente creíble que vincule la baja rentabilidad con el estancamiento. Por un lado, sugiere que la causa del estancamiento es la infrainversión debida a las bajas tasas de beneficios. Pero, al mismo tiempo, afirma que las bajas tasas de beneficios se deben al exceso de inversión. Se podría pensar que años de infrainversión acabarían eliminando el exceso de capacidad o, alternativamente, que un exceso de inversión sin fin sería incompatible con el estancamiento. Pero en la teoría de Brenner, de alguna manera siempre hay una sequía de inversión en toda la economía junto con un exceso de capacidad continuo.

Puede ser tentador suponer que hay algún argumento sutil aquí –tal vez una sequía de inversión en algunos sectores junto a un exceso de capacidad en otros; o tal vez ciclos secuenciales de escasez y exceso–. Pero ni lo uno ni lo otro podrían explicar un estancamiento que es a la vez crónico y continuo y que abarca toda la economía.

Creo que la explicación más probable es la más sencilla: el argumento de Brenner contiene simplemente un error de razonamiento. O, si se prefiere, contiene una tensión no resuelta entre tener el pastel y comérselo también.

Estancamiento creciente

Sin embargo, los problemas más graves de la tesis son empíricos, no teóricos. Parte de la dificultad de lidiar con la teoría de Brenner es que es difícil precisar de qué es una teoría. Brenner la presenta como una explicación de los orígenes del «estancamiento» mundial, pero sin definir nunca, que yo sepa, lo que se entiende por estancamiento. Sin embargo, según el significado llano de la palabra, es difícil ver cómo la economía mundial posterior a 1973 puede calificarse de estancada.

Sin duda, desde 1973 no se han repetido las tasas de crecimiento excepcionalmente elevadas de la posguerra de lo que Brenner denomina «el largo boom». Y en los quince años transcurridos desde el estallido de la Gran Recesión, los países más ricos han experimentado, por término medio, tasas de crecimiento inusualmente lentas.

Pero calificar el período posterior a 1973 como de «estancamiento cada vez peor» para la economía mundial en su conjunto, en el que «algunos países… son capaces de lograr una recuperación sólo a expensas de otros países» –como Aaron Benanav dijo en su reciente defensa de la tesis de Brenner en la New Left Review– es simplemente erróneo.

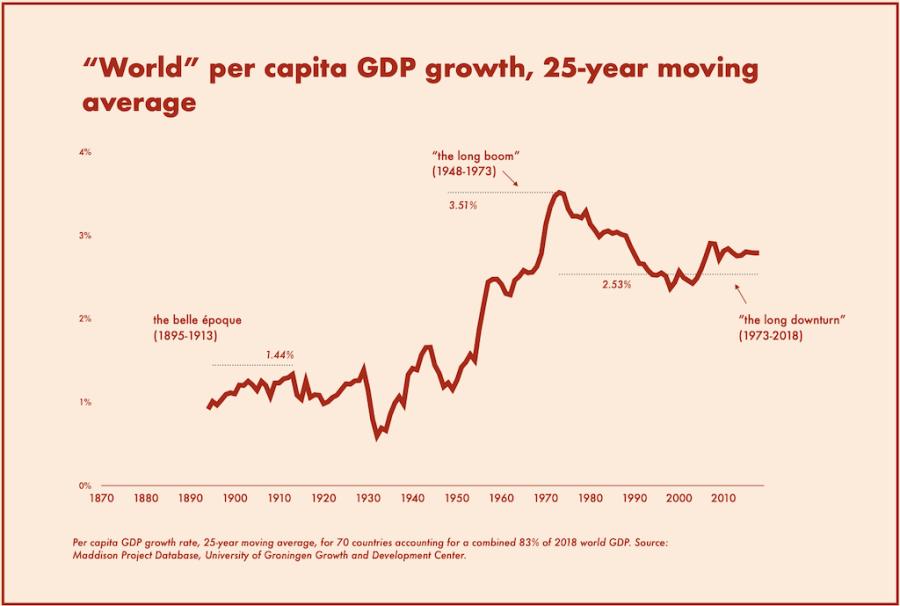

El siguiente gráfico muestra la tasa de crecimiento del PIB per cápita desde 1870 para los setenta países que cuentan con datos que se remontan hasta esa fecha en la base de datos del Proyecto Maddison, la fuente estándar para este tipo de estadísticas. Dado que estos países representan actualmente alrededor del 83% del PIB mundial y tienen una población combinada de 5.600 millones de habitantes, el gráfico puede tomarse como una aproximación a la tasa de crecimiento «mundial».

Las cifras muestran que en el transcurso de la llamada larga recesión (1973 a 2018, el último año del conjunto de datos), la tasa media anual de crecimiento per cápita mundial ha sido del 2,53%, muy por encima tanto de la media histórica (2%) como de la mediana (2,16%) de las tasas de crecimiento de los aproximadamente cuarenta y cinco años (superpuestos) de este periodo. Y ello a pesar de que el periodo en cuestión abarcó la peor crisis financiera desde la Gran Depresión y sus secuelas.

Mientras tanto, el llamado boom largo (1948 a 1973) registró la tasa de crecimiento más alta de cualquier período de veinticinco años en la historia del capitalismo posterior a 1870 (3,51%), lo que lo convierte en un punto de referencia particularmente inapropiado para la comparación.

La caída de la tasa de beneficios: ¿Un espejismo estadístico?

El segundo problema empírico básico de la teoría de la caída de la tasa de beneficios de Brenner tiene que ver con la propia caída de la tasa de beneficios, cuya existencia resulta igualmente cuestionable.

La tasa de beneficios es intrínsecamente difícil de medir. El problema no es tanto la medición de los beneficios, aunque esto presenta una serie de desafíos de datos. Más bien es el denominador, el capital social, el que plantea un grave problema. (Shaikh dedica una parte considerable de las casi 150 páginas de apéndices técnicos de Capitalism: Competition, Conflict, and Crises a los problemas de la medición del stock de capital).

Se supone que el capital social representa la suma, en términos monetarios, de todas las inversiones físicas pasadas (edificios, equipos, programas informáticos, etc.) menos la suma de todas las depreciaciones pasadas de esas inversiones debidas al desgaste o a la obsolescencia. (Hay más complicaciones relacionadas con los precios actuales frente a los históricos, pero las dejaré a un lado).

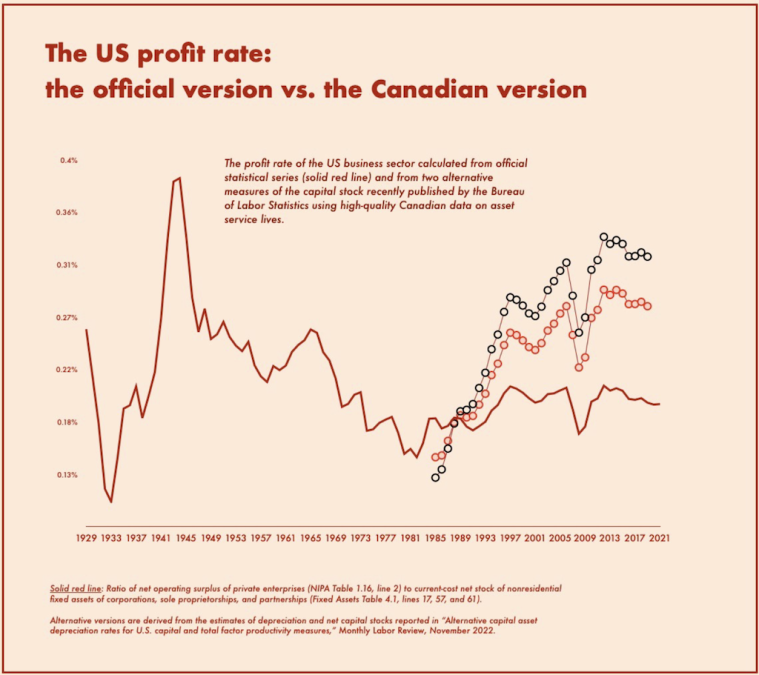

El flujo anual del gasto de inversión es relativamente fácil de medir, pero no puede decirse lo mismo de la depreciación. En Estados Unidos, la cruda realidad es que todas las mediciones oficiales del stock de capital se han basado, durante años, en un único conjunto de estimaciones de las tasas de depreciación de los activos elaboradas por dos académicos, Frank C. Wykoff y Charles R. Hulten, hace más de cuarenta años.

Este es un problema grave, porque incluso pequeños cambios en la vida útil de los activos pueden tener un gran impacto en el stock de capital medido: cuanto más larga sea la vida del activo de capital medio, más años de inversión acumulada se incorporan al stock de capital en un momento dado y, por tanto, menor es la tasa de beneficio medida.

Sin embargo, nuevas investigaciones publicadas por separado por la Oficina de Estadísticas Laborales (BLS) y la Organización para la Cooperación y el Desarrollo Económico (OCDE) han confirmado antiguas sospechas sobre la exactitud, incluso aproximada, de las estimaciones oficiales del stock de capital.

Un documento de la OCDE sobre la medición de la depreciación publicado el pasado enero señala que «los organismos estadísticos de los distintos países tienden a utilizar supuestos muy diferentes en relación con la depreciación y la jubilación de activos», y que las estimaciones de «los patrones de depreciación y jubilación tienden a basarse en pruebas empíricas escasas o en investigaciones antiguas».

A continuación, compara sistemáticamente los métodos utilizados para estimar las existencias de capital en Estados Unidos, Canadá, Reino Unido, Francia, Alemania e Italia, y concluye que en los cinco países no estadounidenses las estimaciones de depreciación son «más altas, o mucho más altas, que las utilizadas en Estados Unidos». La adopción de los métodos estadísticos de otros países «reduciría la tasa de inversión neta y el stock de capital neto del sector privado estadounidense hasta en un tercio», lo que, por supuesto, tendría un gran efecto al alza sobre las tasas de beneficio medidas.

En un artículo publicado el año pasado en la revista Monthly Labor Review de la BLS, un equipo de economistas investigadores de la BLS y la Oficina de Análisis Económico –las dos agencias que elaboran conjuntamente las estadísticas oficiales sobre el stock de capital en EE.UU– demostraron hasta qué punto este efecto sería importante.

Los autores buscaron en Canadá información sobre la medición de la depreciación. Las medidas canadienses del stock de capital se consideran especialmente fiables gracias a una encuesta obligatoria a las empresas realizada anualmente desde mediados de los años ochenta por Statistics Canada, que recoge información sobre los índices de desgaste, obsolescencia, pautas de retirada de activos, valores de reventa, etcétera. Obviamente, se trata de un método superior al uso de un puñado de estudios de hace cuarenta años.

Los investigadores querían ver qué ocurriría con el stock de capital medido en EE.UU. si las cifras canadienses de vida útil de los activos se aplicaran a los datos estadounidenses, por lo que construyeron dos estimaciones alternativas de series temporales de las tasas de depreciación de EE.UU. basándose en las cifras canadienses.

La diferencia en la tasa de beneficios es enorme. Mientras que la tasa de beneficios netos del sector empresarial implícita en las estimaciones publicadas sobre el stock de capital en EE.UU. se estanca entre el 18 y el 20 por ciento durante todo el periodo desde 1985, las estimaciones alternativas que utilizan los patrones de depreciación canadienses muestran que las tasas de beneficios en EE.UU. se duplican, o casi: pasan del 16 por ciento a finales de los 80 al 28 o 32 por ciento en los años anteriores a la pandemia.

La falta de fiabilidad de las tasas de depreciación medidas plantea un problema importante para las teorías de los resultados económicos basadas en la premisa de la caída de las tasas de beneficios porque, como resulta, el descenso de las tasas de beneficios medidas desde la década de 1960 es totalmente atribuible a los cambios en la depreciación medida.

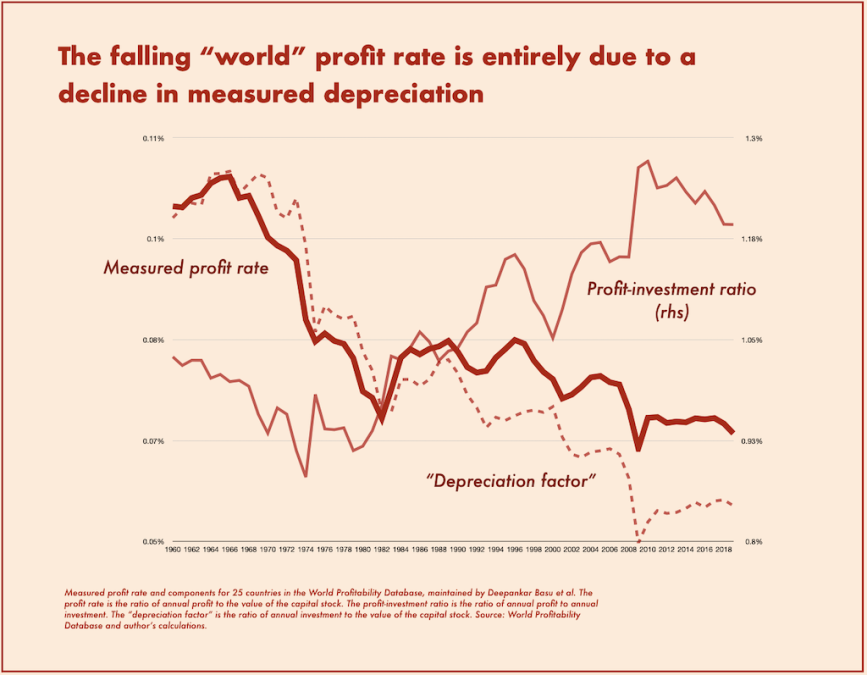

Una forma sencilla de demostrarlo es observar los datos presentados en el World Profitability Dashboard, una herramienta interactiva en línea mantenida por un equipo de economistas marxianos dirigidos por Deepankar Basu, de la Universidad de Massachusetts, basada en su conjunto de datos de tasas de beneficios en docenas de países. El gráfico principal de la página de inicio del dashboard muestra la aparentemente decreciente tasa de beneficio «mundial», es decir, la tasa de beneficio media de los veinticinco países para los que el conjunto de datos contiene datos continuos desde 1960.

Este es el aspecto del gráfico del sitio web:

Para mostrar el impacto de las tendencias (medidas) de depreciación en esta aparente trayectoria descendente, he separado la tasa de beneficios en dos componentes: lo que podríamos llamar la tasa de beneficios «no depreciados», que es simplemente la relación entre el beneficio bruto anual y la inversión bruta anual; y un «factor de depreciación«, la relación entre la inversión bruta anual y el stock de capital medido. La tasa de beneficio es, por definición, el producto de estas dos cifras.

Entre 1960-73 y 1973-2019, la «tasa de beneficio mundial» mostrada por el Cuadro de mando de la rentabilidad mundial se redujo en una cuarta parte (de una media del 9,9% a una media del 7,2%), pero esto se produjo a pesar de un aumento de casi una quinta parte en la tasa de beneficio «no depreciado» (es decir, la relación beneficio-inversión, que aumentó de 0,99 a 1,16). La razón de este descenso fue una disminución de casi el 40% en el factor de depreciación.

No se trata de un arcano tecnicismo. Se supone que la caída de las tasas de beneficio indica que la inversión es cada vez menos remunerativa, que se generan cada vez menos beneficios por cada dólar invertido. Pero los datos muestran claramente que esto no es así: la relación entre el beneficio actual y la inversión actual ha aumentado, no disminuido.

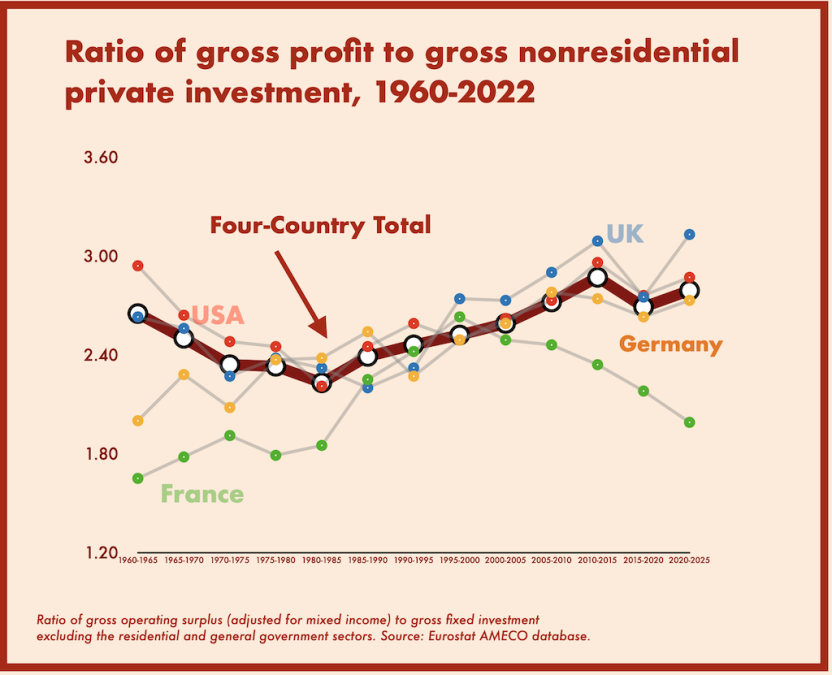

(El conjunto de datos de Basu incluye los sectores gubernamental y residencial en sus datos de inversión, pero el gráfico siguiente, basado en datos de Eurostat, demuestra que el patrón básico se mantiene cuando se excluyen esos sectores, al menos para los cuatro principales países para los que existen esos datos desde 1960).

Fallos de coordinación

«Debería ser evidente», dice Brenner, «por qué, para los revolucionarios, es tan importante su argumento de que los periodos prolongados de crisis están integrados en el capitalismo». Su argumento puede resumirse en tres pasos: (1) las crisis están causadas por la naturaleza anárquica y no planificada del capitalismo; (2) por lo tanto, «los gobiernos no pueden evitar las crisis»; (3) la incapacidad de los gobiernos para evitar las crisis da una razón de ser a la política revolucionaria.

Pero las crisis capitalistas no pueden deberse a la mera ausencia de planificación. Las sociedades precapitalistas también carecían de planificación, y sin embargo (como observó Engels en Anti-Dühring) no tenían crisis. Una crisis es un fallo de coordinación entre las innumerables unidades individuales de una economía: hogares, empresas, señoríos, etc. Las economías precapitalistas no sufrían crisis porque tenían una división del trabajo demasiado limitada para requerir mucha coordinación en primer lugar.

De esto se deduce que cualquier análisis adecuado de la crisis capitalista moderna debe partir, no de la ausencia de planificación, sino de la existencia de una división del trabajo enormemente extendida. Con una división del trabajo muy extendida, las actividades de millones o miles de millones de personas deben coordinarse minuciosamente y cualquier cosa que perturbe esta intrincada coordinación desbarata el engranaje de la producción.

Es la división ampliada del trabajo la que explica la susceptibilidad de todas las economías modernas –capitalistas y de planificación centralizada por igual– a los fallos de coordinación y, por tanto, a las crisis de distintos tipos. En el capitalismo, esos fallos adoptan la forma de déficits de demanda efectiva, que causan desempleo. En el socialismo de planificación centralizada, adoptan la forma de desproporciones tipo Hilferding entre las distintas ramas de la industria, que provocan una escasez endémica. (La escasez, a su vez, provocaba un desempleo encubierto en forma de paros en los talleres: «holgura improductiva» en la terminología de János Kornai).

Brenner tiene razón al ver una conexión entre la recurrencia de «periodos prolongados de crisis» y la perspectiva de una transformación sistémica del modo de producción. Pero se equivoca al ver esto como parte de los argumentos a favor del socialismo. Históricamente, la conexión sólo se ha producido en la dirección «equivocada»: los periodos prolongados de crisis económica han conducido a transiciones del socialismo al capitalismo, pero nunca, hasta ahora, del capitalismo al socialismo.

En la década de 1890, el inicio «repentino y dramático» de un periodo de «prosperidad basado en el auge de los negocios» –como Eric Hobsbawm caracterizó la Belle Époque anterior a la Primera Guerra Mundial en The Age of Empire– hizo «evidente que quienes habían hecho pronósticos sombríos sobre el futuro del capitalismo, o incluso sobre su inminente colapso, se habían equivocado». La polémica revisionista –la primera gran crisis intelectual del marxismo– fue el resultado directo del inesperado retorno del sistema a la vitalidad.

Y sin embargo, este mismo año, Benanav, en su defensa de la tesis de Brenner en la New Left Review, profetizó que «sean cuales sean los altibajos que experimente a lo largo del camino, el capitalismo parece estar agotándose». En efecto, la esperanza es eterna: la tasa de crecimiento mundial en los años de «auge« de la Belle Époque fue del 1,4% de media. En la llamada larga recesión que comenzó en 1973, esa cifra fue del 2,5%.

Seth Ackerman es redactor en Jacobin.

Fuente: Jacobin, 12-9-2023 (https://jacobin.com/2023/09/robert-brenner-marxist-economics-falling-rate-of-profit-stagnation-overcapacity-industrial-policy)