Marxista, date cuenta: la coacción muda se explica también sin Hegel

Quique Badia

1. Resumen

Søren Mau nos regaló en 2023 un libro extraordinario. Coacción muda (Mau, 2023) es un retrato de inusitada finura sobre la forma con la que el poder económico gobierna nuestras vidas, no como un agente vivo y con conciencia, sino impersonalmente, como resultado de una determinada estructura de relaciones. El texto, basado en su tesis doctoral, recoge algunas de las innovaciones teóricas más sugerentes de los últimos años incorporadas al análisis marxista, pero se obstina en mantener la dialéctica como sistema explicativo. Este artículo pretende mostrar que, a día de hoy, disponemos de lenguajes formales mucho más extendidos en un amplio abanico de ciencias y que pueden dar cuenta de lo que Karl Marx entendía por coacción muda.

2. Introducción

Hace ya un tiempo, el agregador de noticias Reddit nos deleitó con el hilarante testimonio de una mujer de 33 años que vivía con desesperación la obsesión de su marido estadounidense de 35 por la figura del viejo Georg Wilhelm Friedrich Hegel. Ella, formada en el ámbito de la física y de ascendencia alemana, explicaba que había intentado interesarse por el objeto de investigación filosófica de su cónyuge, pero arremetía así contra lo que había podido leer de él: «Su trabajo implica afirmaciones que simplemente están mal, pero mal en una manera vergonzante». Y por si esta afirmación no pareciera lo suficientemente denigrante para el estudioso de la filosofía de Hegel, su compañera insistía en que la forma como él concibe la ciencia está «atascada» en ideas del siglo XIX. «Siento que estoy compitiendo por la atención de mi marido con un filósofo de 200 años», culminaba su desesperada publicación. Pretendo defender en este artículo que esto es algo parecido a lo que les sucede a algunos marxistas que se obstinan en encajar sus análisis en el llamado «método dialéctico» hegeliano, y que ya va siendo hora de hacer hablar a la ontología de Karl Marx en los idiomas más extendidos de las ciencias contemporáneas.

Un ejemplo de lo primero es Coacción muda, un libro del filósofo danés Søren Mau (Mau, 2023) que retrata de forma extraordinaria los mecanismos de poder impersonal que obligan a la clase trabajadora a ofrecerse en un mercado en el que otra clase se apropia de parte de su fuerza de trabajo. Para ello, Mau se apoya parcialmente en el mutualismo emergentista que Andreas Malm (Malm, 2018) toma prestado de autores como Carl Gillett (Gillett, 2022) para The Progress of This Storm: Nature and Society in a Warming World. El emergentismo es el paradigma de la filosofía de la ciencia que acepta que de una interacción determinada de partes emergen nuevas propiedades que no muestran las susodichas por separado. El ejemplo clásico de este marco es el del agua, que tiene la capacidad de extinguir el fuego, mientras que sus partes (el hidrógeno y el oxígeno) avivan al mencionado elemento.

Pero los mutualistas aún van más allá y defienden, además, que la totalidad que emerge de un conjunto de partes ejerce un poder causal propio, de manera que partes y totalidad se afectan mutuamente. Para Mau, el mutualismo es una forma de caracterizar la impersonalidad del poder económico, pues retiene la premisa de que el capital en tanto que totalidad tiene efectos sobre nuestras vidas sin necesidad de atribuirle «conciencia, voluntad e intencionalidad». Y sostiene que, bajo este prisma, el mercado es una propiedad emergente que surge del conjunto de relaciones sociales impuestas por la generalización del intercambio mercantil. Llamémosle totalidad concreta, tomando prestada la expresión a Manuel Sacristán (Engels, 1964).

Aunque Mau, como el investigador estadounidense sin nombre que abría el artículo, también considera imprescindible mantenerse fiel a Hegel contra viento y marea. En particular, a su análisis dialéctico, que describe brevemente en estos términos:

«La dialéctica es, más bien, un proceso en el que una totalidad concreta revela su propia negación como uno de sus momentos constitutivos».

Aquí el filósofo danés se refiere al concepto hegeliano de Aufhebung, entendido como una secuencia de negación, preservación y elevación que expresa movimiento. Ciñéndonos al paradigma mutualista y a la descripción de arriba, podemos afirmar que Mau defiende que, de un conjunto determinado de relaciones de producción y explotación, emerge (o se constituye) una totalidad concreta que niega otras totalidades emergentes anteriores con las que convive (o que se preservan), al menos durante un tiempo. Por ejemplo, la emergencia del modo de producción capitalista negó al modo de producción feudal, pero algunos elementos del segundo se mantuvieron hasta que se dio el paso de la elevación.

La concepción de la dialéctica en Mau es sofisticada: en Coacción muda insiste «en que no todos los aspectos de esa totalidad son igualmente constitutivos de cualquiera de sus partes», y cita la noción de «totalidades parciales» de David McNally (McNally, 2017) y a Georg Lukács (Lukács, 1971) cuando afirma que «la categoría de totalidad no supera en modo alguno sus momentos en una unidad indiferenciada, en una identidad».

Igual de sofisticada (y bastante similar) es la forma en la que Andrés Piqueras (Piqueras, 2024) describe la dialéctica, sirviéndose de las aportaciones del sociólogo y filósofo Edgar Morin (Morin, 1998). Morin considera que los sistemas complejos se caracterizan por las propiedades de la interdependencia, la recursividad, la retroalimentación y la emergencia, todas ellas compatibles con algunas de las descripciones de una noción tan inasible como la de dialéctica, que muchos consideran que no es posible representar mediante lenguajes formales. Tanto Mau como Piqueras apuntan, implícitamente, a la necesidad de detallar los mecanismos que concurren en los procesos sociales que estudian, pero cabe preguntarse: ¿hay que insistir en retener a la dialéctica hegeliana? En corto, la respuesta es «no». Y en largo, este artículo pretende demostrar que hoy en día disponemos de lenguajes formales utilizados ampliamente en contextos científicos que permiten mantener las propiedades más relevantes que se le presuponen a la dialéctica.

Pero para argumentar esta hipótesis primero hay que señalar a qué se contraponen los mencionados lenguajes formales. Ni Hegel ni Marx detallaron lo que entendían por «método dialéctico», por lo que es de recibo clarificar qué se va a entender en este artículo por el citado sistema. Y en rigor, para comprender bien las implicaciones de uno u otro lenguaje es indispensable comparar el que se propone en este artículo con las tentativas más recientes y contrastadas de formalizar la dialéctica. Estas son las de Graham Priest, Elena Ficara y Franca d’Agostini (Ficara y Priest, 2023). Los dos primeros autores defienden dos tipos diferentes de lógicas paraconsistentes y la tercera introduce un razonamiento basado en la paradoja de Sorites que permite capturar la noción de emergencia. Esta paradoja permite reflexionar sobre el umbral en el que algo deja de ser una cosa para convertirse en otra mediante preguntas parecidas a «cuántos pelos debe tener alguien en la cabeza para dejar de ser calvo» o «cuántos granos de arena constituyen una montañita del mismo material».

Las tesis defendidas aquí son las siguientes: la lógica clásica, mucho más extendida y contrastada que las lógicas paraconsistentes, nos da un fundamento sólido con el que caracterizar la coacción muda tal y como la conceptualiza Mau. Y una de las consecuencias aparentemente contraintuitivas de esta lógica, la de aceptar la abstracción de que todo lo posible existe de forma necesaria (aunque otra cosa es que sea concreto en una situación actual) es una condición para apoyar conceptualmente al emergentismo mutualista. Esto es porque se asume que las capacidades, entendidas como poderes causales, son propiedades que existen de forma necesaria, pero que para que se manifiesten deben darse unas circunstancias muy concretas. Aunque también se defenderá que el lenguaje con el que analizar los procesos sociales no es tanto el de la lógica modal, constreñida a la intuición, como los modelos causales estructurales (SCM, por sus siglas en inglés), de base estadística. En particular, el lenguaje formal defendido es el de los SCM dinámicos, ya que capturan el movimiento implícito en la Aufhebung hegeliana y las propiedades más relevantes de los sistemas complejos de Morin mediante la asignación de variables de tiempo.

La siguiente sección argumentará la decisión de tomar la lógica clásica como punto de partida con una breve introducción a la llamada filosofía experimental, sin presuponer conocimientos previos al lector. Después se profundizará en los conceptos de necesitismo y capacidades y se explicará cómo funcionan tanto los SCM como los SCM dinámicos. Una vez dispongamos del lenguaje definido, se contrapondrá a las propuestas de formalización de la dialéctica, convenientemente explicadas.

3. Formalizar el pensamiento

3.1. Filosofía experimental

Uno de los paradigmas dominantes en la epistemología y la ontología actuales es el de la filosofía experimental, una aproximación filosófica que defiende que es necesario considerar esta disciplina al mismo nivel que las ciencias naturales, como la física, o de las ciencias no-naturales como las matemáticas; dotándola de lenguajes formales propios, como ya ocurre con otros saberes que se sirven de la aritmética o la estadística para fundamentarse (Williamson, 2021).

Esta forma de hacer filosofía se construye sobre una unidad fundamental: la proposición, que para entender qué significa es necesario distinguirla de la oración y el enunciado.

Una oración es una sucesión de palabras de una lengua bien formada gramaticalmente que nos permite realizar una de las acciones que típicamente hacemos con el lenguaje: comunicarnos. Es una expresión, hablada o escrita, o una expresión pensada.

Los enunciados son un tipo de oración: un tipo sobre el que tiene sentido preguntarse si son verdaderos o falsos. Generalmente, afirmaciones. Una pregunta, un imperativo o un insulto no son enunciados, por ejemplo.

Una proposición es lo que un enunciado dice (significa) o expresa: su referencia. Puede ayudar pensarlas como objetos que habitan el mundo de las ideas en tanto que posibilidades, a la manera platónica, y que podemos capturar mediante enunciados. Así, proposiciones pueden ser, por ejemplo:

– Juan pesa 80 kg

– Hoy hace sol

– 2 + 2 = 4

Es importante entender que una proposición no es un pensamiento, puesto que los pensamientos dependen de la mente.

En los fundamentos de la filosofía analítica, de la que parte la filosofía experimental, existe la asunción de que toda proposición es un objeto independiente de la mente, tal y como lo es un número o una operación matemática (Frege, 1892): es fácil estar de acuerdo con que el 2 referirá siempre lo mismo (dos unidades) y 2 + 2 serán siempre cuatro al margen de lo que tú creas o de que sepas contar. Puede decirse que, de algún modo, son objetos que existen al margen de que nosotros los conozcamos.

Pero si una proposición tanto puede ser que 2 + 2 son 4, como que Juan pesa 80 kg o que hoy hace sol, entonces hay que entender que las dos últimas son tan reales (en tanto que parte de nuestra realidad) como un número o una suma.

El significado de estas proposiciones (entendido como su referencia) no cambia, de igual modo que 2 + 2 = 4 significa una sola cosa: lo que cambia son las llamadas condiciones de verdad que las hacen verdaderas o falsas.

Por condiciones de verdad debemos entender que el valor de verdad de una proposición, es decir, si una proposición es verdadera o falsa, viene dado por el estado de las cosas (o las condiciones) actual o en una situación posible. Esto es, siguiendo un ejemplo dado, que la proposición «hoy hace sol» es verdadera o falsa en función de si hace sol o no en la situación en la que nos encontramos en estos momentos o en una imaginada que queremos evaluar.

De estas asunciones, que se encuentran lejos de ser triviales, se sigue lógicamente que, al igual que los números nos dan respuestas inequívocas cuando trabajamos con unos operadores determinados (mediante operaciones matemáticas), la lógica modal, que permite evaluar las condiciones de verdad de distintas situaciones contrafácticas, es un instrumento privilegiado para pensar la realidad. Hacer nuestro este método, por ejemplo, permite:

Reflexionar sobre las nociones de contingencia y necesidad. Que haga sol o no es contingente: el 3 de abril de 2023 puede hacer sol en Barcelona, pero en otra situación (una imaginada) no, ya que las leyes de la física no determinan una relación causal entre una fecha del calendario y la meteorología, por lo que la proposición es verdadera o falsa en función de unas determinadas condiciones de verdad (que haga sol o no en ese momento concreto). Mientras que 2 + 2 = 4 es una proposición verdadera en toda situación que podamos imaginar, por lo que se trata de una proposición necesaria.

Y disertar sobre si una determinada proposición es una condición suficiente o necesaria. Por ejemplo, la inseguridad emocional imputada a un individuo: muchos dirían que es una condición necesaria para explicar según qué comportamientos violentos, pero también que no es una condición suficiente por sí sola para explicar el ejercicio de la violencia.

3.2. La lógica modal en el estudio del conocimiento

Además, el método de la lógica modal también nos da instrumentos para definir y pensar sobre nociones complejas, como el conocimiento, mediante lo que se llama experimentos mentales.

Un ejemplo de estos experimentos es el reloj de Russell (Russell, 1949), que nos da pistas sobre lo que debemos entender por conocimiento. Es el siguiente:

Imaginemos un reloj estropeado que siempre marca las 12 en punto. Si miramos el reloj exactamente a las 12 en punto, ¿diríamos que conocemos la hora? La lógica modal permite formalizar la imaginación de situaciones en las que cuando miremos el reloj sean las 12 y 5 o las 12 menos 5, donde, claramente, si pensáramos que son las 12 en punto, sostendríamos una proposición falsa.

Siguiendo toda la explicación anterior, una vez que hemos realizado dicha operación, es evidente que existe una situación (la actual en el experimento mental) en la que la hora del reloj parado y la hora real coinciden (ya que se da la circunstancia de que son las 12 en punto), pero no es la situación proyectada (cuando quedan o han pasado 5 minutos de las 12), por lo que podemos afirmar sin dudar que en aquella situación imaginada mediante la lógica modal no hay conocimiento. Y si no hay conocimiento en la situación imaginada, tampoco puede haberla en la actual.

Experimentos como éste llevan a autores como Timothy Williamson, uno de los máximos exponentes de la filosofía experimental, a sostener que, para que haya conocimiento, es necesario (entendiendo por necesario lo que se decía arriba, que sea el caso y, por tanto verdadero, en toda situación posible) que, aplicando la lógica modal, en una situación algo diferente (siguiendo el ejemplo anterior, las 12 y 5 o las 12 menos 5), con un método determinado (mirar un reloj), la proposición (en tanto que objeto independiente de la mente) que logremos siga siendo verdadera (Williamson, 2002). Si lo que miramos es un reloj estropeado (método), siguiendo el ejemplo anterior, esta condición no se da.

De todo esto se siguen varias conclusiones, entre las que podemos destacar dos que cuentan con un amplísimo consenso en la filosofía:

Que el conocimiento es fáctico, es decir, que sólo podemos conocer lo que es el caso.

Y que no podemos considerar conocimiento aquellas situaciones en las que logremos una proposición verdadera por pura suerte, como en el ejemplo del reloj parado.

Pero lógicas hay de muchos tipos, y la que elegimos tiene efectos muy profundos sobre las premisas filosóficas que nos vemos obligados a aceptar.

Williamson, por ejemplo, sostiene que la lógica más adecuada para hacer filosofía es la de inferencia clásica, que tiene entre sus premisas la ley del tercero excluido: esto es, que o bien algo es o no es el caso, sin términos medios.

Esta premisa, aparentemente trivial, le lleva a plantear que todo el proyecto epistemológico (la reflexión filosófica sobre el conocimiento) se basa en evaluar en qué parte de la dicotomía entre ignorancia y conocimiento se encuentra un individuo.

Según Williamson, existe un umbral preciso en el que un sujeto pasa de ignorar a saber. Pero también defiende que, para que haya conocimiento, debe concurrir una condición necesaria: el principio de seguridad, que no es más que interrogarnos si seguiría habiendo conocimiento a partir del uso de un método determinado si el estado de las cosas fuera algo distinto.

Dos ejemplos de estas dos posturas con la proposición «Juan pesa 80 kg»:

Si aceptamos que el conocimiento es fáctico, sólo podemos conocer si, pensando o profiriendo esta proposición, resulta que es el caso de que Juan pese 80 kg. La idea del umbral preciso a traspasar para conocer surge de un razonamiento sorítico: si consideramos las proposiciones Juan pesa 79 kg o 81 kg, entonces no hemos traspasado el umbral del conocimiento. Ahora bien, que consideremos una proposición verdadera es una condición necesaria pero no suficiente para el conocimiento.

El principio de seguridad permite reflexionar sobre la adecuación del método utilizado para conocer una determinada cosa. Si el método utilizado es mirar la papada de Juan en una foto de brazos hacia arriba, estamos todos de acuerdo en que el margen de error es altísimo, y aunque por pura suerte acertáramos, habría consenso suficiente en decir que no nos encontramos en el lado del conocimiento.

3.3. Necesitismo

Como se ha dicho más arriba, apoyar los razonamientos epistemológicos y ontológicos en el uso de la lógica modal de inferencia clásica obliga a asumir posicionamientos filosóficos que pueden parecer contraintuitivos, pero que a poco que se piensen tienen bastante sentido. Ejemplo de esto es el necesitismo (Williamson, 2013).

La historia de la filosofía está constantemente atravesada por discusiones sobre cuáles son los elementos constitutivos de la realidad. Una de ellas es la discusión entre actualistas y posibilistas: entre los que creen que sólo existe lo que ya ha sucedido y los que consideran que la realidad incluye también lo que podría suceder, la posibilidad. Para ejemplificarlo, pensemos en la siguiente proposición:

Es posible que Juan Pablo II hubiera tenido un hijo.

El actualista negaría la existencia del posible hijo de Juan Pablo II, ya que (hasta donde sabemos) el Papa de Roma no tenía ningún hijo; mientras que el posibilista considera que es necesario aceptar al posible hijo del Papa como parte de la realidad, a pesar de que nunca haya nacido. Esta última posición, que a primera vista parece bastante lisérgica, está arraigada en la evidencia de nuestra facultad de imaginar situaciones contrafácticas.

Aceptar la lógica modal de inferencia clásica como instrumento con el que formalizar la existencia de situaciones imaginadas implica asumir que todo lo posible existe de forma necesaria, como si se tratara de una operación matemática tipo 2 + 2 son 4. Así, que hoy haga sol, aunque no lo haga, es una proposición que existe de forma necesaria, y que Juan pese 79 kg, aunque realmente pese 80, también es una proposición necesaria.

Un necesitista diría que, partiendo de la idealización que reposa en toda modelización de la realidad, nosotros o el hijo no nacido de un Papa existimos de forma tan necesaria como un teorema matemático: en todo momento y en toda situación contrafáctica posible, pero que otra cosa es que nuestra existencia o la de los demás objetos mencionados sea concreta en un espacio-tiempo determinado.

Dicho en términos algo más técnicos, que la concreción no es una propiedad esencial de todo lo posible, a efectos de mantener la coherencia del lenguaje formal empleado. Y es la concreción y no la existencia lo que otorga valor de verdad a una determinada proposición en un determinado caso.

Este compromiso filosófico no es más que una posición coherente con la idea de considerar que los razonamientos filosóficos necesitan un lenguaje formal con sus propias abstracciones, como ocurre en otras ciencias. Williamson cree que la filosofía es una ciencia no-natural de la misma forma que lo son las matemáticas, que debe expresarse preferentemente con la lógica más consistente de entre las que disponemos, la clásica, pero que, a diferencia de las matemáticas, se encuentra lejos de ser una ciencia madura.

Y la clave para alcanzar la madurez, dice él, radica en que, como en todo diseño de modelos científicos, es necesario tomar decisiones que pueden ser disputadas, pero a mayor discusión y rigor técnico, asegura, más factible se vuelve alcanzar para la filosofía el nivel anhelado.

3.3.1. Capacidades

Williamson sostiene toda una serie de razones para defender el necesitismo, pero hay una que no menciona que es clave para enfrentar debates relativos a las ciencias de la causalidad: el de las capacidades causales de los objetos.

La filósofa Nancy Cartwright entiende que las leyes estadísticas de la asociación se limitan a describir regularidades, la probabilidad de que un evento o un fenómeno vaya acompañado de otro, por lo que no nos dan lo que necesitamos para capturar las leyes causales.

Un ejemplo clásico es el de la correlación entre el incremento de la venta de helados y los hurtos: ambos son efectos de una misma causa, el calor, que explica tanto que la gente compre más helado como que haya más turistas, blanco habitual de estos robos. Dicho esto, es erróneo afirmar que los helados provoquen hurtos a pesar de que los dos eventos vayan juntos, por lo que para ella, pues, las leyes causales no pueden reducirse a leyes estadísticas funcionales, a leyes de asociación.

Cartwright sostiene que necesitamos el concepto de capacidad, entendido como algo en el mundo que produce algunas actividades. Defiende que, si aceptamos que las propiedades existen y que estas propiedades llevan aparejadas capacidades, entonces debemos asumir que las capacidades existen como objetos independientes de la mente (Cartwright, 1989).

El ejemplo clásico lo tenemos en la afirmación «las aspirinas palian el dolor de cabeza», en el que atribuimos capacidades a este fármaco. Cuando decimos esto, estamos aceptando que la definición de aspirina, su propiedad esencial, es su capacidad de curar dolores de cabeza. El ejemplo es tan intuitivo que resulta muy difícil negar que las capacidades existen.

3.3.2. Capacidades necesarias

Sin embargo, ni Williamson se pronuncia sobre las capacidades, ni Cartwright lo hace sobre el necesitismo, pero el también filósofo Giacomo Giannini apunta que la posición de la segunda, la de la existencia de las capacidades, exige algún tipo de necesitismo (Giannini, 2020).

Para resumir, según Giannini, la identidad de un poder causal (como el de la aspirina) depende de su manifestación, pero para que ese poder se manifieste es necesario que alguien tenga dolor de cabeza, se trague la aspirina y ésta le palie. Mientras esto no ocurre, este poder no se manifiesta, aunque es una propiedad esencial del fármaco.

La defensa de Williamson de que la concreción no es un atributo esencial de los objetos de la lógica, sigue Giannini, es la mejor forma de caracterizar el compromiso con la existencia de poderes causales no manifestados. Es decir: para que una aspirina sea considerada como tal debe tener la capacidad de paliar el dolor de cabeza, de modo que este poder causal es una condición necesaria para la existencia de la aspirina, un poder que existe al margen de que alguien la tome y que se concreta cuando alguien lo hace.

Es así que una posición de motivaciones tan aparentemente técnicas — satisfacer las normas de un lenguaje formal como el de la lógica modal de inferencia clásica — cobra sentido en el debate filosófico.

3.4. Problemas de la lógica modal

Pero fieles al espíritu de la propuesta de Williamson de profundizar en el debate sobre cuál es el lenguaje formal más adecuado para la filosofía, algunos autores han presentado objeciones relevantes a la lógica modal.

El más conocido de ellos es el científico de la causalidad y filósofo Judea Pearl, precursor de los SCM. Para él, los SCM permiten superar la ambigüedad de la noción de similaridad propia de la lógica modal con la que explicar conceptos como el del principio de seguridad referido en la sección 3.2. (Pearl y Mackenzie, 2018).

Recordemos que por «seguridad» debemos entender la imaginación de situaciones contrafácticas ligeramente diferentes que nos permitan evaluar la concurrencia de conocimiento o no en un caso determinado, como en el del reloj parado.

El problema, sostiene Pearl, es que la lógica modal carece de la capacidad expresiva adecuada hasta tal punto que obliga a pensar en la similaridad entre casos de forma exclusivamente intuitiva. No nos permite comunicar de forma precisa casos concretos (en tanto que situaciones contrafácticas ligeramente diferentes), por lo que puede ocurrir que una situación imaginada que alguien considera cercana sea una situación lejana para otro individuo. Aparte, sigue, existe el problema de la representación, o el hecho de que el número de situaciones contrafácticas imaginables tiende al infinito.

Los SCM, a diferencia de la lógica modal, se expresan mediante descripciones matemáticas en las que es posible aplicar pequeñas intervenciones: describir estadísticamente qué sucedería si un determinado factor dejara de actuar sobre una variable determinada, por ejemplo.

Por partes: el promedio de un efecto causal (ACE por sus siglas en inglés) es el resultado de la diferencia promedio entre resultados potenciales de distintos tipos de intervención. Un ejemplo para hacerlo más comprensible es el cálculo del ACE (o la capacidad) de las aspirinas para paliar los dolores de cabeza sobre una población determinada.

Si tú dispones de información relativa a los efectos observados de un tratamiento a base de aspirina, puedes calcular en términos porcentuales la efectividad del fármaco en cuestión sobre el dolor de cabeza comparándolo con lo que ocurre cuando a un individuo no le das la medicación citada.

Pero este tipo de estudios chocan con lo que se conoce como el problema fundamental de la inferencia causal, y es que no podemos saber qué habría pasado si un mismo sujeto hubiera tomado una aspirina en vez de no hacerlo y viceversa, algo que implica retos epistemológicos importantes.

A continuación, un esquema para entender este problema y posibles formas de superarlo con los SCM.

En la siguiente tabla,

i: denota un individuo específico

T: un tratamiento observado (el consumo de aspirina)

Y: un resultado observado (si se ha paliado el dolor de cabeza o no)

Y(1): el resultado potencial después de aplicar el tratamiento

Y(0): el resultado potencial si el tratamiento no se aplica

Los interrogantes denotan el problema fundamental de la inferencia causal, que nos conduce a asumir que todos los individuos denotados por i comparten unas características fisiológicas similares, o dicho de otra forma, que los que siguen el tratamiento y los que no son grupos comparables, homogéneos.

| i | T | Y | Y(1) | Y(0) | Y(1)-Y(0) |

| 1 | 0 | 0 | ? | 0 | ? |

| 2 | 1 | 1 | 1 | ? | ? |

| 3 | 1 | 0 | 0 | ? | ? |

| 4 | 0 | 0 | ? | 0 | ? |

| 5 | 0 | 1 | ? | 1 | ? |

| 6 | 1 | 1 | 1 | ? | ? |

Tabla 1: Ilustración del problema fundamental de la inferencia causal.

Si la condición de la comparabilidad se da, podemos ignorar los interrogantes y obtendremos el resultado

Y(1) = 2/3

Y(0) = 1/3

de cuya diferencia resulta 1/3 o que tomar aspirina incrementa un 33 por ciento la probabilidad de curar un dolor de cabeza.

Ahora bien: con los instrumentos que nos dan los SCM sólo podemos calcular una relación causal mediante un cómputo estadístico, y esto puede ser un problema, ya que una correlación estadística, por mucho que se mantenga muchas veces y en muchas situaciones, no implica necesariamente una relación causal (como en el ejemplo de los helados y los hurtos referido en la sección 3.3.1.). O dicho de otra forma, el ACE es el resultado de la diferencia entre dos cantidades causales, mientras que la correlación resulta de la diferencia entre dos cantidades estadísticas. Y calcular esta diferencia estadística es un peaje necesario para llegar a las cantidades causales del ACE cuando trabajamos con los SCM. Más sobre esta mecánica de peajes en los próximos párrafos.

La no equivalencia entre el ACE y la correlación (o entre causa y asociación) la podemos captar mediante una representación conceptual llamada grafo acíclico dirigido (DAG, por sus siglas en inglés) propia de los SCM que recoge el movimiento asimétrico de las relaciones causales y las correlaciones, facilitando su comprensión y jerarquización, y sin incurrir en defectos formales tales como considerar las causas simétricas.

Los DAG, entre otras ventajas respecto a la lógica modal, nos permiten constatar gráficamente la existencia de los llamados factores de confusión.

Un ejemplo de ello sería la correlación existente entre dormir con los zapatos puestos y levantarse con dolor de cabeza. Ambas variables son el resultado de una causa común: haber bebido mucho la noche anterior, por lo que la correlación existente entre acabar durmiendo con zapatos (una situación que se vuelve más probable cuando se bebe en exceso la noche anterior) y levantarse con dolor de cabeza puede ser estadísticamente significativa y, por tanto, llevarnos a conclusiones equivocadas.

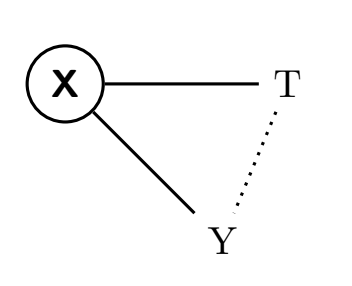

En el siguiente DAG, beber demasiado la noche anterior está representado por X; T representa dormir con los zapatos puestos e Y levantarse con dolor de cabeza. La línea discontinua muestra la correlación entre T e Y, que no es una relación causal, sino estadística, y con la que, a su vez, podemos mostrar gráficamente que el ACE y la correlación no son equivalentes.

Para que el cálculo estadístico sea igual al cálculo causal es necesario asegurar dos cosas:

1. que no existen causas comunes que generen efectos que puedan llevarnos a confundir causa con correlación, y

2. que los individuos estudiados sean comparables.

Siguiendo el ejemplo anterior, captar una relación causal (pasando por el peaje del cálculo estadístico) 1) exige desvincular los efectos del exceso de alcohol (la variable X) del efecto de dormir con zapatos (la variable T) para comprobar si la relevancia estadística entre T e Y se mantiene y 2) garantizar que los grupos comparados (los que duermen con los zapatos puestos y los que no y ambos tienen dolor de cabeza) son homogéneos.

Una forma de hacerlo mediante un experimento sería quitar los zapatos a varios individuos garantizando que el 50 por ciento durmieran con zapatos y el 50 por ciento no y constatar, así, si la correlación estadística entre T e Y se mantiene, que no sería el caso.

Pero incluso si la intervención física no fuera posible, los SCM ofrecen mecanismos de cálculo para aislar los factores de confusión mediante la imaginación de situaciones contrafácticas partiendo de experiencias anteriores.

Todo esto dibuja una jerarquía que Pearl llama la escalera del conocimiento.

En su base está la observación de correlaciones, que llama asociación, una técnica que Cartwright ya consideraba insuficiente para captar si existe o no relación causal.

En medio está la manipulación de variables, que llama intervención, como en el ejemplo de quitar los zapatos a la mitad de las personas que participaban en el experimento del alcohol. La intervención siempre implica aplicar cambios físicamente.

Y en lo alto está la imaginación de situaciones similares con alguna variable cambiada, que llama contrafáctico.

A su juicio, alcanzar conocimiento a la manera humana exige seguir siempre y en orden los pasos establecidos por la escalera y pasar por los peajes de la observación y la intervención.

Nótese que esta noción de conocimiento como producto de evaluaciones de situaciones posibles encaja con la de Williamson que se ha ofrecido arriba.

La motivación de esta propuesta y su forma jerárquica nace de considerar que el lenguaje de la estadística, conjuntamente con instrumentos matemáticos con los que bloquear factores de confusión homogeneizando grupos a comparar, es el único que nos permite describir con precisión los vínculos causales de un fenómeno estudiado.

Autores como Duen-Min Deng también se sirven de los SCM para apuntar (y ofrecer soluciones) a problemas tales como poder decidir qué factores de fondo hay que mantener fijados cuando se imaginan situaciones ligeramente diferentes para evaluar cuestiones epistemológicas u ontológicas, estableciendo tres niveles de modalidad diferenciados y matemáticamente precisos, contra los modelos unidimensionales y exclusivamente intuitivos de la lógica modal de Williamson (Deng, 2016).

Aunque la mecánica sea diferente, asegura este autor, una basada en cálculo estadístico y la otra en intuiciones modeladas por operadores lógicos, pueden permanecer intactos los compromisos filosóficos williamsonianos con la estructura de la inferencia lógica clásica y, por tanto, con el necesitismo.

Para no entrar en detalles técnicos, sólo hay que tener presente que lo relevante de esta sección es poner de manifiesto la posibilidad de utilizar modelos formales más precisos a la hora de identificar la estructura causal de ciertos razonamientos o la jerarquía de causas que explican un determinado fenómeno social.

3.5. SCM dinámicos

Llegados a este punto, es necesario evaluar de qué manera el paradigma mutualista puede expresarse mediante los SCM. Una primera objeción surge claramente a la hora de plantear el mencionado encaje: los SCM se representan mediante DAG, que presuponen que las causas siempre preceden a los efectos, de ahí que describan un movimiento acíclico. El mutualismo, en cambio, asume la concurrencia de una influencia mutua entre un conjunto de partes y la totalidad que emerge de ellas, por lo que nos vemos empujados a la conclusión de que hay que añadir algo al lenguaje formal propuesto.

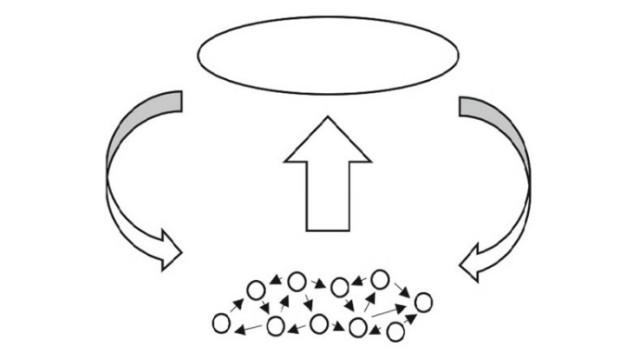

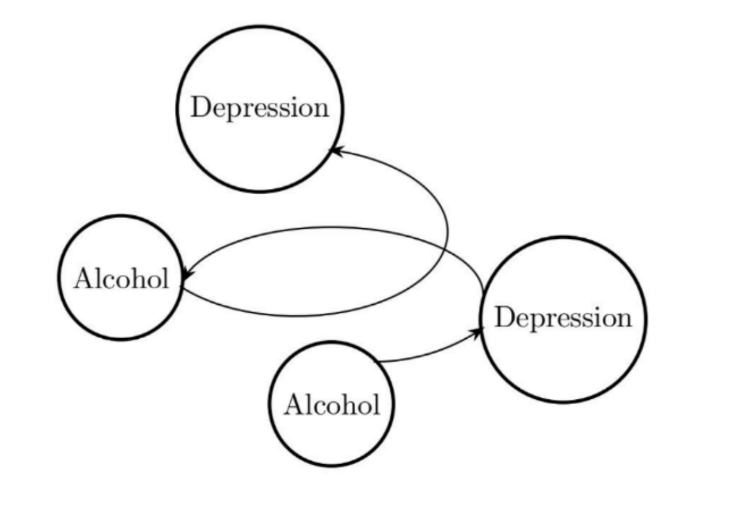

Eleanor J. Murray y Zachary J. Kunicki (Murray y Kunicki, 2022) proponen una estructura de tipo espiral en la que una variable afecta a la otra de forma cronológica. Estos dos autores plantean una lectura alternativa al ejemplo de la relación causal entre alcohol y depresión, una relación muchas veces caracterizada como un bucle de retroalimentación en la que el efecto pasa a ser causa. Para ellos, este tipo de bucles en realidad serían efectos bidireccionales ordenados temporalmente, razón por la que pueden ser representados por los DAG. En esta línea, Philip Boeken y Joris M. Mooij (Boeken y Mooij, 2024) introducen el concepto de SCM dinámicos, las variables endógenas de los cuales representan funciones de tiempo.

Ahora volvamos a la noción de emergencia referida en la introducción. Stuart Glennan (Glennan, 2023) indica que para que esta se dé deben concurrir los siguientes elementos: dependencia, autonomía, novedad y holismo. Así pues, para Glennan, la propiedad emergente se construye en una relación de dependencia con las partes de las que emana, y el fenómeno emergente, para ser considerado tal, debe de ser relativamente autónomo de la fuente que lo origina; disponer de características nuevas y, por lo tanto, ser algo más que la suma de las partes. La hipótesis aquí defendida es que el poder causal de la totalidad concreta emergente permite la manifestación de ciertas capacidades. Gillett sostiene que las totalidades concretas tienen efectos sobre otras totalidades de la misma naturaleza mediante relaciones horizontales densas. Pero también reconoce la existencia de relaciones verticales y más «delgadas» entre algunas capacidades de la totalidad concreta y las capacidades de alguna de las partes.

Expuesto este paisaje conceptual, ahora ya es posible señalar la función de los SCM: fijar la probabilidad de que la capacidad de una totalidad producto de una estructura en particular permita la manifestación de capacidades de alguna de sus partes constitutivas. Un ejemplo de ello nos lo da Malm cuando se refiere a Rex Tillerson, consejero delegado de ExxonMobil y exsecretario de Estado bajo el primer ejecutivo de Donald Trump. En tanto que ser humano, Tillerson representa la mínima unidad de análisis de un sistema social, pero en una determinada estructura causal incrementa la probabilidad de manifestarse en él la capacidad necesariamente humana de gobernar la vida de los demás. O en palabras de Antoni Domènech (Domènech, 1989): la capacidad de definir el conjunto externo de oportunidad que establece los límites en el desarrollo de los individuos que componen una economía concreta. La manifestación de esta capacidad latente garantiza el factor novedad expuesto por Glennan, pues los SCM por sí solos no pueden hacerlo.

La coacción muda, consustancial a la generalización del intercambio mercantil en una sociedad de clases, tiene la capacidad de subyugar a una mayoría social otorgando poderes causales (o capacidades) a personas como la mencionada. Siguiendo a Glennan, el poder de Tillerson depende de la estructura causal de la que emana la coacción muda, que emerge como una propiedad relativamente autónoma de su fuente de origen, en tanto que una relación laboral aislada entre empleado y empleador no la expresa, sino que es el resultado de patrones de relaciones agregadas. Esta propiedad también es un fenómeno nuevo al no manifestarse entre los individuos de una población determinada no sujetos a ciertos modos de producción y que resulta de un complejo entramado de relaciones densas entre totalidades concretas, y de relaciones delgadas entre algunas de las capacidades de esas mismas totalidades y ciertas partes que las componen. En la siguiente sección se va a contraponer este lenguaje a las tentativas de formalización de la dialéctica más consolidadas para evaluar su eficiencia a la hora de expresar las tesis del marxismo.

4. SCM dinámicos contra dialéctica formal

4.1. Formalizar la dialéctica

Ha habido varios intentos a lo largo de la historia de formalizar la dialéctica hegeliana mediante el desarrollo de lógicas no clásicas o sistemas dinámicos, a pesar de que Hegel (Hegel, 2011) criticó la lógica formal. Un libro reciente de Priest y Ficara recoge algunos de estos intentos, incluyendo sus propias contribuciones. Ambos autores proponen una lógica en la que la presencia de contradicciones en unas premisas no suponga una explosión, que es un término técnico con el que referirse al hecho de que, en algunas lógicas (incluyendo las de inferencia clásica), de un conjunto de premisas falsas se sigue cualquier cosa, lo que trivializa el sistema. Es el principio ex contradictione quodlibet, que no opera en las lógicas paraconsistentes. Priest y Ficara se apoyan en estas últimas lógicas para dar un aspecto formal a la dialéctica de Hegel.

No es este el espacio para profundizar en los detalles técnicos de ambas iniciativas, que resuelven la secuencia de negación, preservación y elevación propia de la Aufhebung de diferente manera. Baste con decir que Priest opta por un tipo de negación complementaria que no actúa como un operador que impone una eliminación, sino que implica transformación productiva y captura una noción de movimiento mediante contraposición. Esto supone añadir un tercer valor a la verdad y la falsedad de la lógica clásica: el de verdadero y falso a la vez. Priest no acaba de abandonar del todo la inferencia clásica, pues para él, cuando una proposición es verdadera, su negación es falsa, y al revés. Pero cuando una proposición es verdadera y falsa a la vez su negación sigue siendo ambas cosas. Llama a esta aproximación dialeteismo, que él mismo reconoce que no captura todos los aspectos de la dialéctica: tan solo la Aufhebung.

Un ejemplo en Marx de contradicción que Priest estudia es la concurrencia simultánea de valor de uso y valor de cambio en una mercancía. Las formas valor de uso y valor de cambio se excluyen mutuamente o, en términos hegelianos, se niegan la una a la otra, de manera que, cuando se acepta que el oro tiene, a la vez, un valor de uso y un valor de cambio, tenemos la siguiente secuencia de proposiciones:

El oro tiene valor de uso (una proposición que llamaremos p)

El oro tiene valor de cambio (una proposición que llamaremos no-p (¬p), en tanto que niega la precedente)

El oro tiene valor de uso y valor de cambio (p y ¬p, una conjunción que en lógica clásica implicaría falsedad, pero que en el dialeteismo expresa preservación de contrarios)

El oro deviene dinero por este carácter dual y contradictorio (expresado como pdx, que indica una elevación de la contradicción de la que resulta una nueva categoría social)

La estrategia que esboza Ficara junto a JC Beall es otra. Igual que Priest, ambos siguen una secuencia lógica de contraposiciones, en su caso de tres pasos. En los dos primeros, estas autoras preservan la lógica clásica, por lo que la contradicción p y ¬p es real y, por lo tanto, expresa falsedad. Pero luego culminan esta contradicción con la introducción de una conjunción propia, la conjunción-h (de Hegel), que se comporta de una manera diferente a la conjunción estándar. Así, la preservación de la negación y posterior elevación la resuelven con una conjunción extralógica, frente a la negación que no ejerce eliminación en el caso de Priest. Esto les permite limitar las contradicciones verdaderas (o existentes) tan solo a aquellas expresadas en la conjunción-h, disolviendo problemas asociados al debilitamiento generalizado de la negación que sugiere Priest, señalado por autores como Lorenzo Peña (Peña, 1996). Ambas aportaciones encajan en la noción de dialógica de Morin, que presupone la coexistencia de realidades antagonistas o complementarias.

De este tipo de lógicas también se puede inferir emergencia, tal y como señala d’Agostini. Esta autora parte de la interpretación que Hegel lleva a cabo de la paradoja de Sorites y sostiene con ello que las pruebas soríticas remiten a casos en los que «tiene cierto sentido la idea de contradicciones no simplificables». Esto es así porque en los casos limítrofes (recordemos el ejemplo de los pelos en la cabeza de un calvo y los granos de arena que forman una montañita) se dan situaciones del tipo p y ¬p, cuando nos encontramos en el terreno de la vaguedad ontológica. De esta manera, según d’Agostini, Hegel lo que hace es generalizar los casos de vaguedad y, con ellos, los procesos en los que emergen nuevas propiedades, como la de ser calvo (si vamos arrancando pelos uno a uno) o ser una montaña (si vamos añadiendo granos de arena uno a uno).

4.2. Objeciones a la dialéctica formal

La primera y más obvia objeción que puede hacerse a las lógicas que pretenden capturar formalmente la dialéctica hegeliana es su poca utilidad en el campo de la investigación. Se trata de dispositivos confinados en el reino de la lógica filosófica, atados en corto a la intuición, como sucede con la lógica modal de inferencia clásica, también poco útil en este menester. Es objeto de disputa como traducir la complejidad de ciertos fenómenos a expresiones lógicas, en general, y paraconsistentes, en particular. Y también es discutible lo que se entiende por contradicción en las lógicas paraconsistentes, pues en lenguaje clásico, siguiendo el ejemplo anterior, la negación de «el oro tiene valor de uso» es «el oro no tiene valor de uso», no «el oro tiene valor de cambio».

La ventaja de los SCM dinámicos radica i) en su popularidad, pues Pearl cuenta con decenas de miles de citas a sus obras (y otras tantas citas acumuladas en la discusión sobre los SCM en general que son difíciles de cuantificar), y ii) en su forma matemática y de base estadística, comprensible en prácticamente todos los campos científicos. Fundamentar un análisis marxista en modelos estadísticos es una práctica que otros como Erik Olin Wright (Wright, 2023) ya han explorado y que este artículo no sólo reivindica sino que anima a profundizar, proponiendo el desarrollo de este marco interpretativo en el terreno de las ciencias de la causalidad.

Las lógicas paraconsistentes carecen de la capacidad expresiva de los SCM dinámicos, pues no permiten representar la dirección en la que las capacidades de un objeto (un individuo o una formación social) produce cambios en el mundo, ni definir variables temporales, ni establecer hipótesis relativas a qué vínculos son causales o qué otros actúan como factores de confusión. También tienen dificultades para expresar en detalle conjuntos de interacciones complejas de los que emergen totalidades concretas, así como las relaciones horizontales densas entre estas mismas totalidades y las relaciones verticales delgadas entre totalidad y parte.

5. Conclusión

La discusión sobre la forma con la que caracterizar el análisis marxista ha vivido un impulso significativo en los últimos años tras la publicación de obras de gran impacto en esta temática. La incorporación de paradigmas de la filosofía de la ciencia como el mutualismo o el de los sistemas complejos en el marxismo van en la buena dirección, pero la insistencia en preservar la dialéctica hegeliana es más un obstáculo que una ayuda cuando hoy disponemos de lenguajes formales ampliamente utilizados que pueden darnos todo lo que necesitamos. Estos son la lógica clásica y los SCM dinámicos, que permiten caracterizar la emergencia de totalidades concretas con poderes causales propios mediante la noción de capacidades necesarias que se manifiestan en configuraciones estructurales específicas. Esta propuesta muestra muchas más ventajas que las que ofrecen las tentativas más actuales y trabajadas de formalizar la dialéctica.

Referencias

Boeken, P., & Mooij, J. M. (2024). Dynamic Structural Causal Models. https://arxiv.org/abs/2406.01161

Cartwright, N. (1989). Nature’s Capacities and their Measurement. Clarendon Press.

Deng, D.-M. (2016). «Structural models for Williamson’s modal epistemology». Structural analysis of non-classical logics: The proceedings of the second Taiwan philosophical logic colloquium, 57-81.

Domènech, A. (1989). De la ética a la política: De la razón erótica a la razón inerte. Crítica.

Engels, F. (1964). La subversión de la ciencia por el señor Eugen Dühring. Grijalbo.

Ficara, E., & Priest, G. (Eds.). (2023). The Formalization of Dialectics. Routledge.

Frege, G. (1892). On sense and reference.

Giannini, G. (2020). Powers for Dispositionalism: A Metaphysical Ground for New Actualism [Tesis doctoral, Durham University].

Gillett, C. (2022). «Scientific Emergentism and the Mutualist Revolution: A New Guiding Picture of Nature, New Methodologies and New Models». En S. Wuppuluri & I. Stewart (Eds.), From Electrons to Elephants and Elections: Exploring the Role of Content and Context (pp. 79-98). Springer International Publishing.

Glennan, S. (2023). «The Mechanisms of Emergence». En J. L. Cordovil, G. Santos & D. Vecchi (Eds.), New Mechanism Explanation, Emergence and Reduction (pp. 213-234). Springer.

Hegel, G. W. F. (2011). Ciencia de la lógica I: La lógica objetiva. 1. El ser (1812) // 2. La doctrina de la esencia (1813). Abada Editores.

Lewin, R. (1993). Complexity: Life at the Edge of Chaos. Maxwell Macmillan International.

Lukács, G. (1971). History and Class Consciousness: Studies in Marxist Dialectics. MIT Press.

Malm, A. (2018). The Progress of This Storm: Nature and Society in a Warming World. Verso.

Mau, S. (2023). Coacción Muda: Una Teoría Marxista del Poder Económico del Capital. Verso.

McNally, D. (2017). «Intersections and Dialectics: Critical Reconstructions in Social Reproduction Theory». En T. Bhattacharya (Ed.), Social Reproduction Theory: Remapping Class, Recentering Oppression (pp. 94-111). Pluto Press.

Morin, E. (1998). Introducción al pensamiento complejo. Gedisa.

Murray, E., & Kunicki, Z. (2022). As the Wheel Turns: Causal Inference for Feedback Loops and Bidirectional Effects.

Pearl, J., & Mackenzie, D. (2018). The book of why: the new science of cause and effect. Basic books.

Peña, L. (1996). «Graham Priest’s Dialetheism – Is It Althogether True?» Sorites, 7, 28-56.

Piqueras, A. (2024). De la Decadencia de la Política en el Capitalismo Terminal. El Viejo Topo / Ediciones de Intervención Cultural.

Russell, L. (1949). «Human Knowledge—Its Scope and Limits» 1. Philosophy, 24 (90), 253-260.

Williamson, T. (2002). Knowledge and its Limits. Oxford University Press, USA.

Williamson, T. (2013). Modal logic as metaphysics. Oxford University Press.

Williamson, T. (2021). The philosophy of philosophy. John Wiley & Sons.

Wright, E. O. (2023). Clase, crisis y Estado. Verso.

Pingback: Educar en la totalidad capitalista por Quique Badia Masoni – La Opinión de Óscar Iglesias